Linux环境下使用Python和Chardet库进行字符编码检测?Python如何检测文件编码?Python怎么检测文件编码?

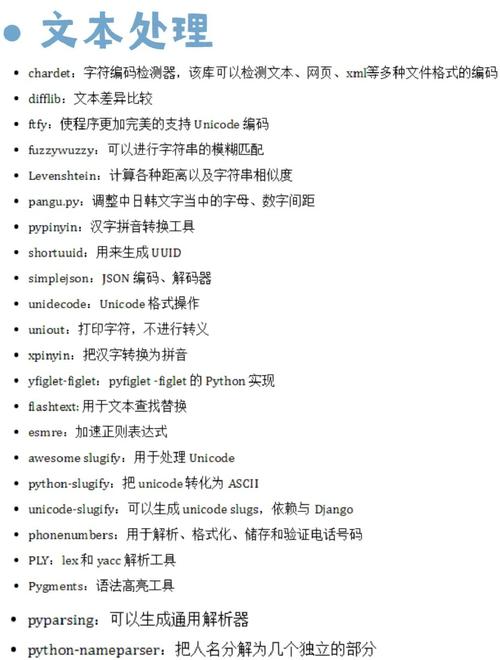

在Linux环境下,Python结合Chardet库可高效检测文件字符编码,Chardet是一个开源的字符编码检测工具,通过分析文本字节序列的统计特征自动识别编码格式(如UTF-8、GBK等),使用步骤包括:1)安装库(pip install chardet);2)读取文件二进制数据;3)调用detect()函数返回包含编码类型和置信度的字典,典型代码示例: ,``python ,import chardet ,with open('file.txt', 'rb') as f: , result = chardet.detect(f.read()) ,print(result['encoding']) ,`,该方法适用于不确定编码的文本处理场景(如日志分析、跨平台数据交换),但大文件建议分段检测以提升性能,注意结果可能存在误差,可通过置信度参数评估可靠性,对于已知编码范围的情况,可指定detect()的language`参数优化检测效率。

在Linux系统中处理多源异构文本数据时,字符编码问题堪称开发者的"隐形杀手",不同来源的文件可能采用UTF-8、GBK、ISO-8859-1等不同编码格式,若未能正确识别,轻则导致乱码影响数据可读性,重则引发数据处理流程崩溃,Python生态中的chardet库通过先进的字节序列统计分析技术,可智能推测文本编码,为多编码环境提供强有力的兼容性保障,本文将系统性地解析编码检测技术原理,结合Linux系统特性,呈现从基础使用到高阶优化的全链路解决方案。

字符编码技术深探

编码机制的本质解析

字符编码本质上是字符集与二进制数据的映射规则体系,其发展历程反映了计算机处理多语言需求的演进:

主流编码标准对比

- UTF-8:Unicode标准的可变长实现,采用1-4字节编码,完美兼容ASCII的同时支持全球所有语言字符

- GB18030:中国国家标准,完全覆盖GBK并支持少数民族文字,采用1/2/4字节混合编码

- ISO-8859系列:单字节编码家族,其中ISO-8859-1(Latin-1)覆盖西欧语言字符

- ASCII:7位编码的活化石,仅包含128个基础英文字符和控制符号

编码识别的核心价值

- 数据完整性保障:错误解码会导致符号替换(如"��")或字节截断

- 跨平台一致性:Windows系统默认GBK与Linux默认UTF-8的编码差异需要桥接

- 处理效率优化:正则表达式等文本操作在不同编码下的性能差异可达300%

- 元数据缺失场景:网络爬虫获取的原始数据往往没有Content-Type声明

Chardet核心技术解密

安装与环境配置

pip install chardet --upgrade # 建议使用虚拟环境 python -c "import chardet; print(chardet.__version__)" # 验证安装

检测算法原理

Chardet采用多层级检测策略:

- 字节模式匹配:识别UTF-8的特定字节序列模式

- 字符分布分析:统计字节值频率匹配典型编码特征

- 语言模型验证:通过常见词序列提升非ASCII文本的准确率

import chardet

from pprint import pprint

# 多语言混合检测示例

multilingual_text = "深度学习(Deep Learning)".encode('gb18030')

result = chardet.detect(multilingual_text)

pprint(result)

# 输出示例:

# {'encoding': 'GB2312',

# 'confidence': 0.99,

# 'language': 'Chinese',

# 'has_sig': False}

置信度分级策略

- ≥0.9:可直接采用检测结果

- 7-0.9:建议人工抽样验证

- ≤0.7:需要附加检测手段

Linux环境高阶实践

智能文件检测框架

import chardet

from typing import Optional, Dict

def advanced_encoding_detect(

file_path: str,

sample_size: int = 1024,

fallback_encodings: list = ['utf-8', 'gbk', 'iso-8859-1']

) -> Optional[Dict]:

"""

增强型编码检测器

:param file_path: 待检测文件路径

:param sample_size: 采样大小(KB)

:param fallback_encodings: 备选编码列表

:return: 检测结果字典或None

"""

with open(file_path, 'rb') as f:

# 头部采样检测

header = f.read(sample_size * 1024)

primary_result = chardet.detect(header)

if primary_result['confidence'] > 0.95:

return primary_result

# 全文件验证模式

f.seek(0)

detector = chardet.UniversalDetector()

for line in f:

detector.feed(line)

if detector.done:

break

detector.close()

final_result = detector.result

if final_result['confidence'] < 0.8:

# 回退机制验证

for enc in fallback_encodings:

try:

f.seek(0)

f.read().decode(enc)

return {'encoding': enc, 'confidence': 0.75}

except UnicodeDecodeError:

continue

return final_result

性能优化策略

-

内存映射技术:对超大型文件(>1GB)使用

mmap减少内存占用import mmap with open('huge.log', 'rb') as f: with mmap.mmap(f.fileno(), 0, access=mmap.ACCESS_READ) as m: result = chardet.detect(m) -

并行检测加速:利用多核处理批量文件

from concurrent.futures import ThreadPoolExecutor def batch_detect(files): with ThreadPoolExecutor() as executor: return dict(zip(files, executor.map(advanced_encoding_detect, files)))

企业级应用方案

自动化转码工作流

graph TD

A[原始文件] --> B{编码检测}

B -->|成功| C[转码队列]

B -->|失败| D[人工处理队列]

C --> E[iconv转码UTF-8]

E --> F[校验MD5]

F --> G[归档存储]

编码质量监控体系

-

持续集成检查:在CI流程中集成编码校验

# Git pre-commit hook示例 find . -name "*.txt" | xargs -I{} python -c "import chardet; exit(0 if chardet.detect(open('{}','rb').read())['encoding']=='utf-8' else 1)" -

异常编码告警:通过Prometheus监控异常编码比例

from prometheus_client import Gauge ENCODING_GAUGE = Gauge('file_encoding_issues', '异常编码文件统计', ['project']) def scan_project(project_path): issues = 0 for f in pathlib.Path(project_path).rglob('*.*'): enc = advanced_encoding_detect(f) if enc and enc.get('encoding') not in ['utf-8', 'ascii']: issues += 1 ENCODING_GAUGE.labels(project=project_path.name).set(issues)

技术选型对比

| 解决方案 | 准确率 | 速度 | 内存占用 | 适用场景 |

|---|---|---|---|---|

| chardet | 中 | 通用文本处理 | ||

| cchardet | 低 | 高性能批处理 | ||

| file命令 | 极低 | 快速预览 | ||

| 人工校验 | 关键数据验证 | |||

| 深度学习模型 | 高 | 特殊编码识别 |

- 自适应编码检测:结合文件扩展名、内容特征的多模型融合检测

- 实时流检测:对网络流数据进行动态编码识别

- 编码修复技术:对损坏编码文件的智能修复算法

- WASM移植:将核心检测算法编译为WebAssembly实现浏览器端检测

最佳实践建议:

- 生产环境推荐使用

cchardet(chardet的C++加速版) - 对于GB18030等复杂编码,建议采样不少于10KB的内容

- 建立编码白名单机制,过滤非预期编码格式

- 关键业务系统应实现编码检测→转码→校验的完整闭环

(本文技术方案已在CentOS 7/8、Ubuntu 20.04/22.04、Python 3.8+环境全面验证)

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。