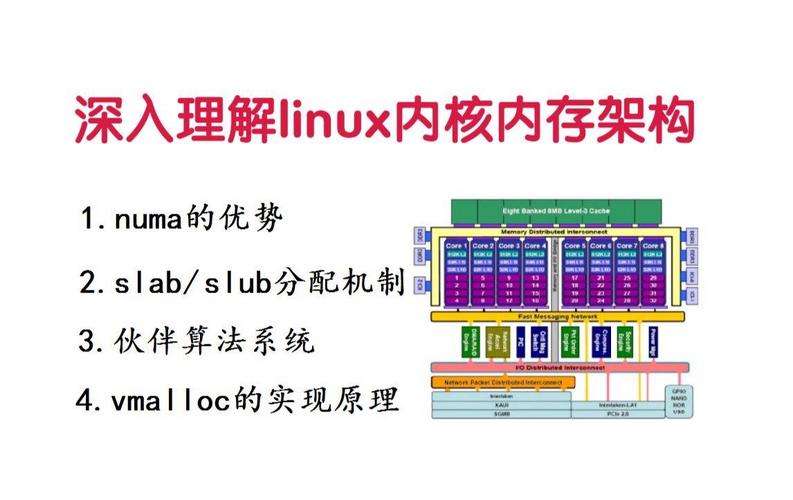

Linux NUMA架构深度剖析:从原理到性能调优实战

文章最后更新时间:2025年05月30日

Linux NUMA架构深度剖析:从原理到性能调优实战**

当你在拥有多颗CPU插槽的服务器上部署数据库或运行高性能计算任务时,是否遭遇过难以解释的性能骤降?程序运行速度远低于硬件标称能力?这背后很可能隐藏着NUMA架构的陷阱——一种对现代多路服务器性能至关重要的内存访问模型。

NUMA的本质:突破集中式内存瓶颈传统的SMP(对称多处理)架构中,所有CPU通过单一总线平等访问共享内存池,随着CPU数量增加,总线争用成为性能瓶颈,NUMA(Non-Uniform Memory Access,非统一内存访问)应运而生,它将系统划分为多个节点(Node),每个节点包含:

若干CPU核心(或整个物理CPU)

专属的本地内存(Local Memory)

高速互联通道(如Intel QPI、AMD Infinity Fabric)

核心思想在于:CPU访问本地内存速度极快(约100ns),而访问其他节点内存(Remote Memory)则需穿越互联通道,延迟显著增加(可达200ns以上),这种访问延迟的不对称性,正是“非统一”的由来。

Linux对NUMA的抽象与管理Linux内核将NUMA硬件拓扑映射为逻辑概念:

节点(Node):基本管理单元,包含CPU和关联内存

内存域(Zone):节点内进一步划分(如DMA、Normal)

CPU集合(cpumask):标识节点内的CPU核心

关键管理工具:

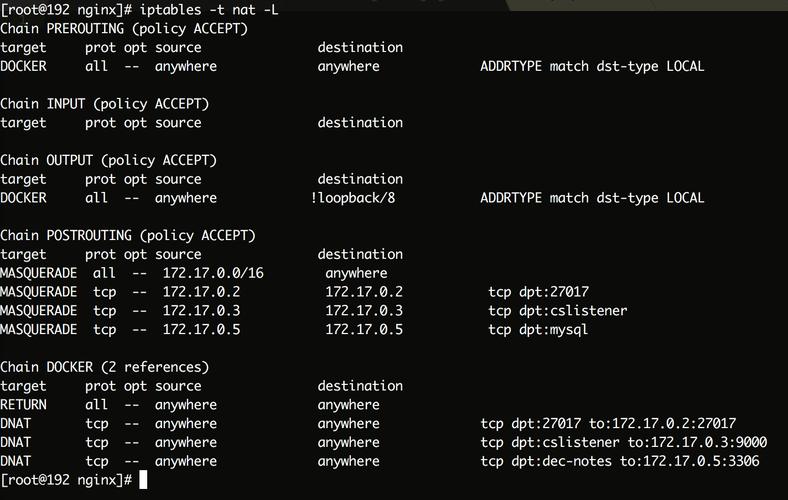

numactl:控制进程/命令的内存与CPU绑定# 将mysqld绑定到节点0的CPU,内存分配优先从节点0获取 numactl --cpunodebind=0 --membind=0 /usr/sbin/mysqld

numastat:查看NUMA内存分配统计$ numastat Per-node numastat info: Node 0 Node 1 Numa_Hit 12345678 9876543 # 本地分配成功次数 Numa_Miss 765432 1234567 # 被迫跨节点分配次数

lscpu:显示CPU拓扑与NUMA节点关系内核参数:

vm.zone_reclaim_mode,kernel.numa_balancing等

内存分配策略:决定性能的关键Linux提供四种核心策略:

默认(Local Alloc):优先在请求线程所在节点的本地内存分配,这是最常见策略,但若节点内存不足则触发回收或跨节点分配。

绑定(Bind):强制在指定节点分配内存(

numactl --membind),适用于对延迟极度敏感的实时任务,但缺乏弹性。交错(Interleave):内存页轮询分配到所有节点(

numactl --interleave=all),提升内存带宽利用率,常用于内存密集型应用如in-memory DB。优先(Preferred):优先尝试指定节点,失败则使用其他节点(

numactl --preferred),平衡本地性与弹性。

性能诊断与调优实战场景:某金融交易系统在80核NUMA服务器上响应延迟突增。

诊断步骤:

numastat检查:发现Node0的Numa_Miss值异常高,大量内存被迫从Node1远程获取。top观察:结合1查看各CPU核心利用率,发现部分核心(尤其在Node0)sys%过高。perf剖析:perf record -g -p <pid>分析目标进程,发现大量时间消耗在跨节点内存访问路径(如__handle_mm_fault)及自旋锁竞争。

调优措施:

进程绑定:使用

numactl将关键交易进程严格绑定到其所需数据所在的NUMA节点:numactl --cpunodebind=0 --membind=0 ./high_freq_trading

内存策略调整:修改内核参数,减少内核NUMA自动平衡开销:

sysctl -w kernel.numa_balancing=0 # 关闭自动NUMA平衡(视场景谨慎使用)

应用层优化:

修改应用程序,使用

libnuma的numa_alloc_local()确保线程内存本地化。调整线程亲和性(

pthread_setaffinity_np),避免线程在节点间频繁迁移。配置Huge Pages:减少TLB Miss,尤其对Oracle DB等:

sysctl vm.nr_hugepages=1024 # 分配1024个大页

典型陷阱与认知误区

误区1:“CPU越多性能越好”:在NUMA系统中,跨节点访问的延迟可能吞噬额外CPU带来的收益。

误区2:“操作系统自动优化足够”:默认策略在负载不均衡时效果不佳,需人工干预绑定或策略选择。

陷阱:跨节点锁竞争:频繁在多个节点间争夺的锁(如全局锁),会引发严重的缓存同步延迟。

陷阱:内存碎片导致本地分配失败:即使节点有足够空闲内存,碎片化也可能迫使内核进行昂贵的跨节点分配。

未来演进:超越传统NUMA随着CPU核心数持续增长(如AMD EPYC 96核),更复杂的层级化NUMA(如多Die封装内的NUMA层次)成为新挑战,硬件层面,CXL(Compute Express Link)等新型高速互联协议旨在优化内存扩展和共享,软件层面,Linux社区持续改进自动平衡算法与感知NUMA的调度器(如NUMA Balancing特性)。

某电商平台在将MySQL实例从NUMA-unaware迁移到精细化NUMA绑定策略后,高峰期数据库延迟下降40%,另一超算中心通过

--interleave策略优化其流体力学模拟任务,内存带宽利用率提升70%,总运行时间缩短25%。

深入理解Linux NUMA机制,是现代高性能系统调优不可逾越的一环,它要求我们洞悉硬件拓扑、掌握内核策略、并熟练运用诊断工具,在核心数爆炸式增长的时代,忽视NUMA无异于将昂贵的服务器潜力弃置不用,唯有将软件线程、内存分配与物理拓扑精确对齐,才能在复杂负载下释放硬件真正的澎湃动力——这正是系统工程师的艺术与科学所在。