Linux存储类别详解,从基础到高级存储管理?Linux存储管理有哪些门道?Linux存储管理真有那么难?

Linux存储管理涵盖从基础到高级的多层次技术,主要包括以下几类:**物理存储**(HDD/SSD)、**逻辑卷管理(LVM)**(支持动态扩容与快照)、**文件系统**(如ext4/XFS/Btrfs)以及**网络存储**(NFS/iSCSI),基础操作涉及分区工具(fdisk/parted)、格式化与挂载,而高级管理则需掌握LVM的卷组、逻辑卷调配,以及RAID(冗余阵列)配置。**存储虚拟化**(如Ceph分布式存储)和**容器存储**(OverlayFS)也日益重要,优化技巧包括IO调度算法调整(CFQ/Deadline)、SSD TRIM支持及文件系统日志优化,理解这些门道能显著提升系统性能与数据可靠性,适应从单机到云环境的多样化需求。

Linux存储管理全景解析:从物理介质到分布式架构

存储管理的多维视角

Linux存储管理构成现代IT基础设施的核心支柱,其技术栈涵盖:

- 基础层:磁盘分区(MBR/GPT)、文件系统(ext4/XFS/Btrfs/ZFS)及挂载管理

- 逻辑层:LVM动态卷管理、RAID(0/1/5/6/10)冗余架构

- 网络层:NFS/iSCSI共享存储、Ceph/GlusterFS分布式方案

- 优化层:SSD TRIM管理、缓存策略(bcache/dm-cache)、容器存储驱动(OverlayFS/DeviceMapper)

本文将从硬件选型到集群部署,系统剖析Linux存储技术栈的最佳实践。

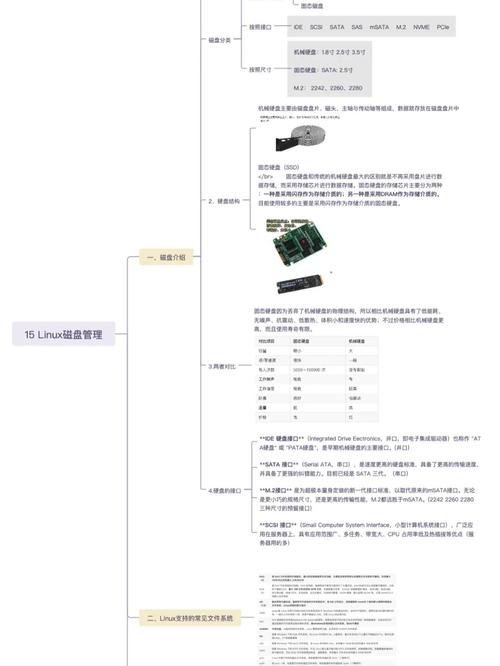

第一章 物理存储设备深度评测

1 机械硬盘(HDD)技术细节

设备标识:

Linux中识别为/dev/sdX设备,可通过hdparm -I /dev/sdX获取详细参数

性能特征:

| 参数 | SATA HDD | SAS HDD |

|-----------------|----------------|----------------|

| 转速 | 5400-7200 RPM | 10K-15K RPM |

| 平均延迟 | 5-8ms | 2-4ms |

| 持续传输率 | 120-200MB/s | 200-300MB/s |

| 随机IOPS | 70-150 | 150-300 |

运维要点:

- 使用

smartctl监控SMART参数(重点关注Reallocated_Sector_Ct) - 避免频繁启停(调整

/sys/block/sdX/device/control的autosuspend参数) - 大规模部署时采用交错启动(staggered spin-up)

2 固态存储技术演进

NVMe协议栈优势:

┌─────────────┐ ┌─────────────┐ │ 应用层 │ │ 传统SCSI │ ├─────────────┤ ├─────────────┤ │ NVMe驱动 │←──→│ SATA/AHCI │ ├─────────────┤ ├─────────────┤ │ PCIe传输层 │ │ SATA通道 │ └─────────────┘ └─────────────┘

性能对比测试:

--ioengine=libaio --iodepth=256 --numjobs=4 \

--runtime=60 --group_reporting --name=nvme_test

关键优化参数:

- 设置

noop调度器:echo noop > /sys/block/nvme0n1/queue/scheduler - 启用多队列:

echo 0 > /sys/block/nvme0n1/queue/nomerges - 调整NR_requests:

echo 1024 > /sys/block/nvme0n1/queue/nr_requests

第二章 高级存储管理技术

1 LVM高级应用场景

精简配置(Thin Provisioning)工作流:

graph TD

A[创建物理卷] --> B[建立卷组]

B --> C[创建精简池]

C --> D[分配精简卷]

D --> E[自动扩展监测]

缓存加速实战:

# 创建缓存池 lvcreate --type cache-pool -L 10G -n lv_cache_pool vg_data # 将慢速卷转换为缓存卷 lvconvert --type cache --cachepool vg_data/lv_cache_pool vg_data/lv_home

2 软件RAID进阶配置

RAID6重建优化:

# 调整重建速度(避免影响业务) echo 50000 > /proc/sys/dev/raid/speed_limit_min echo 200000 > /proc/sys/dev/raid/speed_limit_max # 使用XFS重构优化 mkfs.xfs -d su=64k,sw=4 /dev/md0

RAID级别选择矩阵: | 需求场景 | 推荐RAID | 空间利用率 | 读性能 | 写性能 | |-------------------|----------|------------|--------|--------| | 高性能临时存储 | RAID0 | 100% | ★★★★★ | ★★★★★ | | 关键业务数据库 | RAID10 | 50% | ★★★★☆ | ★★★★☆ | | 归档存储 | RAID6 | (N-2)/N | ★★★☆☆ | ★★☆☆☆ |

第三章 文件系统技术选型指南

1 企业级文件系统对比

ZFS核心优势:

- 数据完整性:256位校验和(可检测并修复静默数据损坏)

- 自适应记录大小:自动匹配I/O模式(4K~1MB动态调整)

- 混合存储池:SSD缓存分层配置示例:

zpool create tank \ mirror /dev/sda /dev/sdb \ cache nvme0n1 \ log mirror nvme1n1 nvme2n1

2 面向容器的存储方案

OverlayFS架构解析:

Upper Dir (可写层) │ ├── Merged View (呈现给容器) │ Lower Dir (只读镜像层)

性能调优建议:

- 禁用索引节点校验:

mount -o index=off - 使用xfs作为底层文件系统(避免docker默认的ext4导致inode耗尽)

- 为/var/lib/docker单独挂载高性能存储

第四章 分布式存储实战

1 Ceph集群设计原则

硬件配置黄金比例:

- 每OSD进程分配:

- 4-8 CPU线程

- 4GB内存基础 + 每TB存储1GB额外内存

- 1Gbps网络带宽/每OSD(10Gbps推荐)

CRUSH算法调优:

# 自定义故障域规则 ceph osd crush add-bucket rack1 rack ceph osd crush move rack1 root=default ceph osd crush set osd.0 1.0 rack=rack1

2 性能优化案例

RBD缓存策略:

[client] rbd cache = true rbd cache size = 1G rbd cache max dirty = 512M rbd cache target dirty = 384M

第五章 前沿存储技术展望

-

持久内存应用:

- 使用

ndctl工具配置PMEM命名空间 - 在K8s中通过PMEM-CSI驱动提供容器存储

- 使用

-

NVMe-oF架构:

NVMe Initiator ←FC/RDMA→ NVMe Target ↓ Storage Fabric (延迟<10μs) -

智能存储加速:

- 使用SPDK(Storage Performance Development Kit)实现用户态I/O栈

- 基于FPGA的压缩/加密卸载引擎

构建可持续的存储体系

建议从以下维度建立存储治理框架:

- 性能维度:建立IOPS/吞吐量/延迟的SLA指标

- 成本维度:采用ILM(信息生命周期管理)分层存储

- 安全维度:实施3-2-1备份策略(3份副本,2种介质,1份离线)

- 演进维度:定期评估Ceph/ZFS等新技术的适用性

通过本文的技术路线图,可系统掌握Linux存储管理的核心方法论,应对从边缘计算到云原生的各类存储挑战。