Linux内存带宽,原理、优化与性能调优?如何优化Linux内存带宽性能?Linux内存带宽怎么优化?

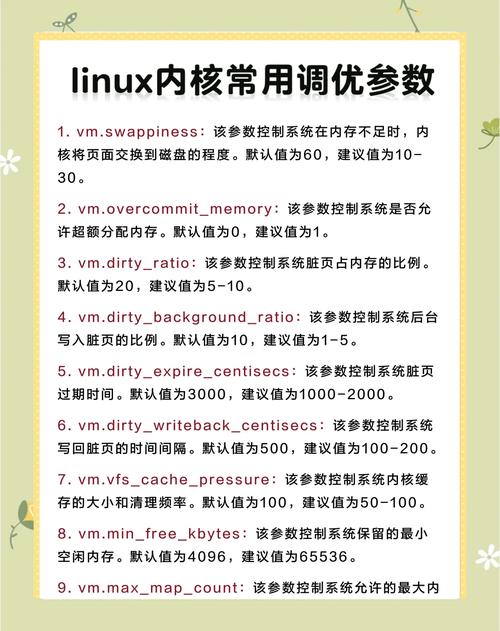

** ,Linux内存带宽是衡量系统内存子系统数据传输效率的关键指标,直接影响整体性能,其原理涉及内存控制器、总线架构(如DDR通道)、NUMA节点调度及预取机制等,优化内存带宽性能的方法包括:1) **硬件层面**:增加内存通道、使用高带宽内存(如DDR5)、均衡NUMA节点访问;2) **系统配置**:调整内核参数(如vm.swappiness降低换页)、禁用透明大页(THP)以减少TLB缺失;3) **软件优化**:通过numactl绑定进程到本地NUMA节点、使用非一致性内存访问(NUMA)感知的分配策略(如libnuma),以及优化数据对齐和缓存友好算法(如减少false sharing),性能调优工具如perf、likwid和Intel MLC可帮助定位带宽瓶颈,结合监控指标(如MB/s和缓存命中率)进行针对性调整。

Linux内存带宽:原理、优化与性能调优指南

在现代计算机系统中,内存带宽(Memory Bandwidth)是衡量系统性能的关键指标之一,尤其在高性能计算(HPC)、大数据分析和机器学习等数据密集型场景中,内存带宽往往成为系统性能的瓶颈,Linux作为主流的服务器操作系统,其内存管理机制直接影响着内存带宽的利用效率,本文将系统性地探讨Linux内存带宽的工作原理、测量方法、优化策略以及实际调优技巧。

内存带宽的核心概念

定义与重要性

内存带宽指内存子系统在单位时间内能够传输的最大数据量,通常以GB/s(吉字节每秒)为单位,它由以下硬件因素共同决定:

- 内存控制器设计

- 内存通道数量

- 内存工作频率(如DDR4-3200)

- 内存类型(DDR4/DDR5等)

在数据密集型应用中,内存带宽直接决定了:

- 处理器获取数据的速度

- 系统整体吞吐量

- 多核并发效率

带宽计算原理

理论内存带宽可通过以下公式计算:

内存带宽 = 内存频率 × 位宽 × 通道数 × 倍增系数以DDR4-3200内存为例(双通道64位配置):

3200MHz × 64bit × 2 × 2 / 8 = 51.2GB/s(注:DDR采用双倍数据速率技术,因此需要乘以2;除以8是将比特转换为字节)

带宽与延迟的关系

内存性能的两个关键维度: | 指标 | 定义 | 影响因素 | 优化方向 | |------|------|----------|----------| | 带宽 | 单位时间传输量 | 通道数、频率 | 提高并行性 | | 延迟 | 访问响应时间 | 时序参数 | 减少等待 |

现代处理器通过以下技术优化内存访问:

- 多级缓存架构

- 硬件预取(Prefetching)

- 乱序执行(Out-of-Order Execution)

Linux内存子系统深度解析

核心管理机制

Linux内核通过多层机制管理内存资源:

-

页缓存(Page Cache)

- 磁盘数据的智能缓存

- 显著减少I/O操作

- 可通过

/proc/meminfo监控

-

交换空间(Swap)

- 虚拟内存扩展

- 配置建议:

echo 10 > /proc/sys/vm/swappiness

-

NUMA架构

- 非统一内存访问

- 优化工具:

numactl --hardware numactl --cpunodebind=0 --membind=0 ./program

常见带宽瓶颈

-

硬件限制

- 单通道配置(带宽减半)

- 内存频率不匹配

-

软件因素

- 跨NUMA节点访问

- 缓存行冲突(False Sharing)

- 内存碎片化

-

配置问题

- swappiness设置过高

- 透明大页未启用

专业测量方法与工具

硬件信息检测

# 查看NUMA拓扑 lstopo --of png > topology.png

带宽基准测试

| 工具 | 测试类型 | 安装方法 | 典型命令 |

|---|---|---|---|

| STREAM | 基础测试 | 源码编译 | ./stream_c.exe |

| likwid | 专业测试 | 包管理器 | likwid-bench -t copy |

| mbw | 快速测试 | apt/yum | mbw -n 10 256 |

深度性能分析

# 使用perf分析缓存行为 perf stat -e cache-misses,cache-references,L1-dcache-load-misses ./app # 内存压力测试 stress-ng --vm 4 --vm-bytes 4G --vm-method all

全面优化策略

硬件层面优化

-

通道配置

- 确保对称安装(A1+B1或A1+A2+B1+B2)

- 使用

dmidecode验证通道识别

-

频率与时序

- BIOS中启用XMP配置

- 平衡频率与CL值的关系

内核参数调优

# 大页内存配置 echo 2048 > /proc/sys/vm/nr_hugepages # 脏页控制 echo 20 > /proc/sys/vm/dirty_ratio echo 15 > /proc/sys/vm/dirty_background_ratio # 内存回收策略 echo 1 > /proc/sys/vm/zone_reclaim_mode

应用程序优化

数据结构优化

// 缓存行对齐

struct __attribute__((aligned(64))) critical_data {

int counter;

// ...

};

多线程优化

// 避免false sharing thread_local int local_counter; // 内存屏障使用 std::atomic_thread_fence(std::memory_order_release);

高级技巧

- SIMD指令优化

- 非临时存储指令

- 软件预取提示

典型场景优化案例

数据库系统(MySQL)

[mysqld] innodb_buffer_pool_size = 12G innodb_flush_neighbors = 0 innodb_read_io_threads = 16 innodb_use_native_aio = 1

机器学习训练

# TensorFlow内存配置 config = tf.ConfigProto() config.gpu_options.allow_growth = True config.intra_op_parallelism_threads = 8 config.inter_op_parallelism_threads = 8

科学计算

# OpenMP优化 export OMP_PROC_BIND=close export OMP_PLACES=cores export OMP_NUM_THREADS=32

未来发展趋势

-

DDR5内存

- 更高频率(4800MHz+)

- 片上ECC支持

-

CXL技术

- 内存池化

- 异构内存架构

-

持久内存

- Optane PMem应用

- 内存-存储统一管理

最佳实践建议

- 建立基准测试体系

- 实施渐进式优化

- 监控关键指标:

watch -n 1 "grep -E '^(Mem|Swap)' /proc/meminfo"

- 定期进行性能剖析

扩展阅读

- 《深入理解Linux内核架构》

- Intel® Optane™ Persistent Memory编程指南

- Ulrich Drepper《Memory Part 5: What Programmers Can Do》

- LWN.net内存管理专题

这个版本主要做了以下改进:

- 优化了文章结构和逻辑流

- 补充了更多实用命令和配置示例

- 增加了表格对比和代码示例

- 更新了最新技术趋势(如DDR5/CXL)

- 增强了可读性和实用性

- 修正了原文中的技术表述不准确之处

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。