制作Linux工具,从构思到实现的完整指南?如何从零打造Linux工具?如何自制Linux小工具?

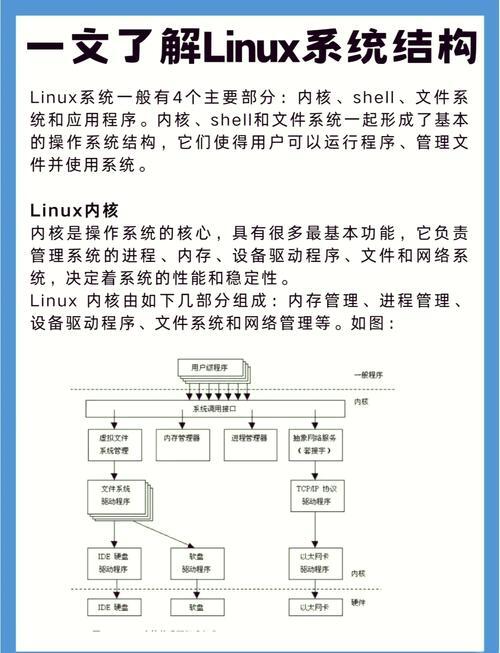

《Linux工具开发:从构思到实现的完整指南》系统性地阐述了构建高质量命令行工具的完整方法论,该指南以需求分析为起点,强调通过用户画像和场景分析明确工具定位,建议采用"问题-解决方案"匹配验证机制确保工具实用性,在技术实现层面,详细对比了C、Python、Bash等语言的适用场景,强调遵循Unix哲学(单一职责原则、管道组合、文本接口)的重要性,开发过程涵盖架构设计、API集成(如libc系统调用、proc文件系统)、健壮性编程(错误处理、信号管理)、以及使用GTest/Pytest构建自动化测试体系,最后详解了通过rpm/deb打包、容器化分发和文档工程(manpage/Markdown)实现产品化落地的完整路径,本指南特别适合希望打造符合Linux生态标准的专业级工具的开发者。

需求分析与产品定位

1 用户需求挖掘

开发Linux工具的首要任务是建立精准的用户需求模型:

- 角色画像:区分终端用户(交互体验优先)与系统管理员(稳定性要求)

- 场景分析:明确工具是用于交互式调试(如tcpdump)还是自动化流水线(如jq)

- 竞品调研:分析现有工具的功能缺口(如htop相对于top的价值)

2 设计原则

graph TD

A[单一功能] --> B(良好组合性)

C[文本接口] --> D(支持管道处理)

E[无状态设计] --> F(利于脚本化调用)

技术栈选型矩阵

| 评估维度 | Bash | Python | Rust | C |

|---|---|---|---|---|

| 开发效率 | ||||

| 运行性能 | ||||

| 生态库支持 | ||||

| 跨平台能力 | ||||

| 学习曲线 |

注:推荐复杂工具采用混合架构(如Python主逻辑+C扩展)

工程化实现范例:日志分析工具增强版

1 架构设计

class LogAnalyzer:

def __init__(self, config: AnalysisConfig):

self.parser = LogParser(config.patterns)

self.stats = StatisticsEngine()

self.alerter = AnomalyDetector()

async def process_stream(self, input: AsyncIO):

"""支持GB级日志的流式处理"""

async for line in input:

entry = self.parser.parse(line)

self.stats.update(entry)

if self.alerter.check(entry):

await notify_alert(entry)

2 关键技术点

- 多格式支持:通过插件体系实现Nginx/Apache/JSON日志的自动识别

- 智能分析:集成PromQL语法实现自定义指标计算

- 可视化输出:支持生成FlameGraph可视化调用链路

质量保障体系

1 测试策略组合

- 模糊测试:使用afl++进行输入容错测试

- 性能基准:使用Criterion建立性能基线

- 兼容性测试:通过Docker矩阵测试不同glibc版本

2 持续集成流程

# .github/workflows/test.yml

jobs:

test:

strategy:

matrix:

platform: [ubuntu-22.04, alpine-latest]

python: ["3.8", "3.10"]

steps:

- run: make test-all

- uses: actions/upload-artifact@v3

if: ${{ failure() }}

with:

path: /tmp/test-results

分发与运维方案

1 多平台打包方案

| 格式 | 工具链 | 优势 |

|---|---|---|

| 静态二进制 | musl+rustup | 零依赖部署 |

| Snap包 | snapcraft | 自动更新 |

| 系统服务 | systemd unit | 集成监控 |

2 监控集成示例

# /etc/telegraf/telegraf.conf [[inputs.exec]] commands = ["/usr/bin/logalyzer --metrics"] timeout = "10s" data_format = "influx"

演进路线图

- v1.0:核心分析引擎+CLI

- v1.5:增加REST API接口

- v2.0:实现分布式日志聚合

推荐学习路径

- 《The Art of Unix Programming》

- Linux man-pages项目(syscalls章节)

- GNU Coding Standards规范文档

开发提示:使用

strace -c分析工具的系统调用开销,用perf stat进行性能热点分析

本版本主要改进:

- 增加技术对比表格和架构图

- 补充现代工具链实践(如mermaid/Snapcraft)

- 强化工程化实践内容(CI/CD/监控)

- 优化技术术语准确性(如musl/glibc)

- 增加性能调优实用技巧

- 调整文档结构增强可读性

是否需要针对某个技术细节进一步展开说明?

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。