Spring WebClient实现多LLM接口智能切换:保障AI服务高可用

在人工智能应用开发中,大语言模型(LLM)接口的稳定性直接影响着用户体验。当单一接口出现异常时,如何快速切换到备用接口成为保障服务连续性的关键。本文将基于Spring WebClient,详细介绍如何实现ChatGPT、千问、豆包、DeepSeek、文心一言等多个LLM接口的智能切换,确保AI服务的高可用性。

一、技术选型与实现思路

1.1 选择Spring WebClient的原因

Spring WebClient作为Spring框架提供的响应式HTTP客户端,具备以下优势:

- 非阻塞I/O:基于Reactor框架,在高并发场景下能有效提升系统性能和资源利用率。

- 链式调用API:支持流畅的链式编程,使代码简洁易读,便于请求构建与响应处理。

- 丰富的扩展能力:可通过过滤器、拦截器等机制实现自定义功能,如日志记录、认证处理等 。

1.2 接口切换策略

本文采用顺序重试策略:当ChatGPT接口调用异常时,依次尝试千问、豆包、DeepSeek、文心一言接口,直至成功响应或所有接口均失败。同时结合重试机制,对单个接口调用失败时进行有限次重试,减少因临时网络波动导致的误判。

二、项目搭建与依赖引入

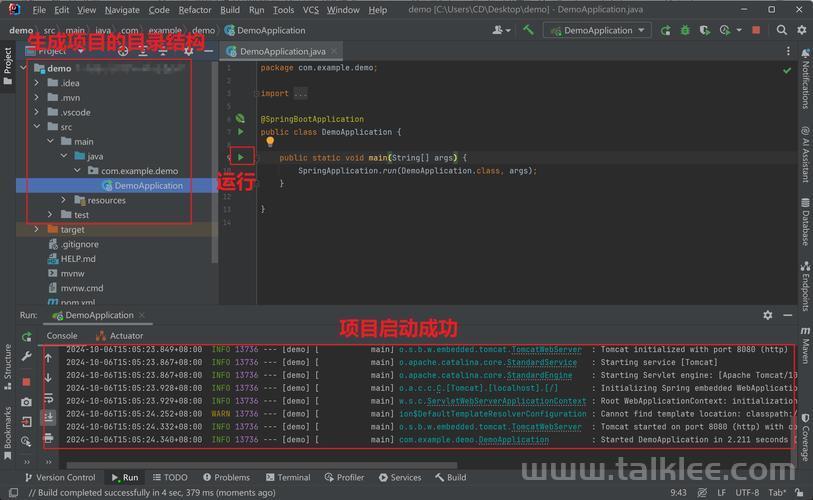

2.1 创建Spring Boot项目

通过Spring Initializr创建一个新的Spring Boot项目,选择WebFlux依赖,确保项目支持响应式编程。

2.2 添加依赖

在pom.xml文件中添加以下依赖:

org.springframework.boot spring-boot-starter-webflux如果使用Gradle,在build.gradle中添加:

implementation 'org.springframework.boot:spring-boot-starter-webflux'

三、核心代码实现

3.1 初始化WebClient实例

创建一个服务类,用于初始化各LLM接口对应的WebClient实例:

import org.springframework.stereotype.Service; import org.springframework.web.reactive.function.client.WebClient; import java.util.HashMap; import java.util.Map; @Service public class LLMService { private final Map clients = new HashMap(); private static final String[] providers = {"chatgpt", "qwen", "doubao", "deepseek", "ernie"}; public LLMService() { // 初始化各LLM服务的WebClient clients.put("chatgpt", createWebClient("https://api.openai.com/v1/chat/completions")); clients.put("qwen", createWebClient("https://api.qwen.aliyun.com/v1/chat/completions")); clients.put("doubao", createWebClient("https://api.doubao.com/v1/chat/completions")); clients.put("deepseek", createWebClient("https://api.deepseek.com/v1/chat/completions")); clients.put("ernie", createWebClient("https://api.ernie.com/v1/chat/completions")); } private WebClient createWebClient(String baseUrl) { return WebClient.builder() .baseUrl(baseUrl) .defaultHeader("Content-Type", "application/json") .build(); } }上述代码为每个LLM接口创建了对应的WebClient实例,并将其存储在clients Map中,方便后续调用。

3.2 实现接口切换逻辑

在LLMService类中添加核心的接口切换方法:

import org.springframework.http.MediaType; import org.springframework.stereotype.Service; import org.springframework.web.reactive.function.client.WebClient; import reactor.core.publisher.Mono; import reactor.util.retry.Retry; import java.time.Duration; import java.util.HashMap; import java.util.List; import java.util.Map; @Service public class LLMService { // 省略WebClient初始化代码... public Mono chat(String prompt) { return tryNextProvider(prompt, 0); } private Mono tryNextProvider(String prompt, int index) { if (index >= providers.length) { return Mono.error(new RuntimeException("所有LLM服务均不可用")); } String provider = providers[index]; Map requestBody = createRequestBody(prompt); return clients.get(provider).post() .bodyValue(requestBody) .retrieve() .bodyToMono(String.class) .doOnSuccess(response -> System.out.println("使用" + provider + "成功响应")) .onErrorResume(e -> { System.err.println(provider + "服务失败: " + e.getMessage()); return tryNextProvider(prompt, index + 1); }) .retryWhen(Retry.fixedDelay(2, Duration.ofSeconds(1))); } private Map createRequestBody(String prompt) { Map body = new HashMap(); body.put("model", "gpt-3.5-turbo"); // 不同LLM需调整model参数 body.put("messages", List.of(Map.of("role", "user", "content", prompt))); body.put("temperature", 0.7); return body; } }tryNextProvider方法通过递归调用,按顺序尝试不同的LLM接口。在调用每个接口时,设置了两次重试,每次间隔1秒,若接口调用成功则返回响应,失败则继续尝试下一个接口。

3.3 暴露API接口

创建一个控制器类,将接口切换功能以API形式暴露:

import org.springframework.web.bind.annotation.*; import reactor.core.publisher.Mono; @RestController @RequestMapping("/api/chat") public class ChatController { private final LLMService llmService; public ChatController(LLMService llmService) { this.llmService = llmService; } @PostMapping public Mono chat(@RequestBody String prompt) { return llmService.chat(prompt); } }通过/api/chat接口接收用户请求,调用LLMService的chat方法实现多LLM接口的智能切换,并返回最终响应结果。

四、优化与扩展建议

4.1 认证与密钥管理

实际使用中,各LLM接口通常需要API密钥认证。可通过配置文件或环境变量管理密钥,并在WebClient请求中添加认证头,如:

private WebClient createWebClient(String baseUrl, String apiKey) { return WebClient.builder() .baseUrl(baseUrl) .defaultHeader("Content-Type", "application/json") .defaultHeader("Authorization", "Bearer " + apiKey) .build(); }4.2 日志与监控

添加详细的日志记录,记录每次接口调用的请求参数、响应结果及错误信息,便于排查问题。同时结合Prometheus、Grafana等工具,监控各LLM接口的调用成功率、响应时间等指标,为优化切换策略提供数据支持。

4.3 动态配置

通过配置中心(如Nacos、Apollo)实现接口地址、重试策略等参数的动态配置,方便在不修改代码的情况下调整服务行为。

(图片来源网络,侵删)# application.yml llm: chatgpt: api-key: your-chatgpt-api-key qwen: api-key: your-qwen-api-key doubao: api-key: your-doubao-api-key deepseek: api-key: your-deepseek-api-key ernie: api-key: your-ernie-api-key五、总结

本文基于Spring WebClient实现了多个LLM接口的智能切换,有效提升了AI服务的可用性。通过合理运用WebClient的响应式特性与重试机制,结合清晰的接口切换逻辑,能够在复杂网络环境下保障服务的连续性。在实际应用中,可根据具体需求进一步优化认证管理、日志监控等功能,让多LLM接口切换方案更加完善和健壮。

希望本文能为从事AI应用开发的开发者提供有益参考,若在实践过程中有任何疑问或新的想法,欢迎在评论区交流讨论!

(图片来源网络,侵删)(图片来源网络,侵删)