【AI大模型前沿】MedReason:大规模医学推理数据集、借用知识图谱将大模型打造成医术专家

系列篇章💥

| No. | 文章 |

|---|---|

| 1 | 【AI大模型前沿】深度剖析瑞智病理大模型 RuiPath:如何革新癌症病理诊断技术 |

| 2 | 【AI大模型前沿】清华大学 CLAMP-3:多模态技术引领音乐检索新潮流 |

| 3 | 【AI大模型前沿】浙大携手阿里推出HealthGPT:医学视觉语言大模型助力智能医疗新突破 |

| 4 | 【AI大模型前沿】阿里 QwQ-32B:320 亿参数推理大模型,性能比肩 DeepSeek-R1,免费开源 |

| 5 | 【AI大模型前沿】TRELLIS:微软、清华、中科大联合推出的高质量3D生成模型 |

| 6 | 【AI大模型前沿】Migician:清华、北大、华科联手打造的多图像定位大模型,一键解决安防监控与自动驾驶难题 |

| 7 | 【AI大模型前沿】DeepSeek-V3-0324:AI 模型的全面升级与技术突破 |

| 8 | 【AI大模型前沿】BioMedGPT-R1:清华联合水木分子打造的多模态生物医药大模型,开启智能研发新纪元 |

| 9 | 【AI大模型前沿】DiffRhythm:西北工业大学打造的10秒铸就完整歌曲的AI歌曲生成模型 |

| 10 | 【AI大模型前沿】R1-Omni:阿里开源全模态情感识别与强化学习的创新结合 |

| 11 | 【AI大模型前沿】Qwen2.5-Omni:阿里巴巴的多模态大模型,实现看、听、说、写一体化 |

| 12 | 【AI大模型前沿】SmolDocling:256M参数的轻量级多模态文档处理利器,10分钟搞定百页PDF |

| 13 | 【AI大模型前沿】Stable Virtual Camera:Stability AI 推出的2D图像转3D视频模型,一键生成沉浸式视频 |

| 14 | 【AI大模型前沿】阿里 Qwen3 震撼开源,模型新王诞生,开启全球大模型新纪元 |

| 15 | 【AI大模型前沿】InternVL:OpenGVLab开源多模态大模型,解锁视觉问答与多语言翻译的全能应用图鉴 |

| 16 | 【AI大模型前沿】Fin-R1:上海财经大学联合财跃星辰推出的金融推理大模型,凭7B参数拿下评测第二,离行业第一仅差3分 |

| 17 | 【AI大模型前沿】Med-R1:基于强化学习的医疗视觉语言模型,突破跨模态医学推理的普适性 |

| 18 | 【AI大模型前沿】Baichuan-M1-14B:百川智能推出专为医疗优化的开源大语言模型 |

| 19 | 【AI大模型前沿】一键生成宫崎骏动画风,EasyControl Ghibli 让照片秒变吉卜力艺术品 |

| 20 | 【AI大模型前沿】TxGemma:谷歌推出的高效药物研发大模型,临床试验预测准确率超90% |

| 21 | 【AI大模型前沿】F5R-TTS:腾讯推出TTS领域的新王者,又快又准又自然,零样本语音克隆新高度 |

| 22 | 【AI大模型前沿】MiniMind-V:低成本打造超小多模态视觉语言模型(仅需1.3元人民币和1小时) |

| 23 | 【AI大模型前沿】MoCha:端到端对话角色视频生成模型、电影级对话角色合成黑科技、重新定义动画创作 |

| 24 | 【AI大模型前沿】HuatuoGPT-o1-7B:中英文双语医学推理,打破语言障碍的AI大模型 |

| 25 | 【AI大模型前沿】MedReason:大规模医学推理数据集、借用知识图谱将大模型打造成“医术”专家 |

目录

- 系列篇章💥

- 前言

- 一、项目概述

- 二、技术原理

- (一)医学实体提取与映射

- (二)路径搜索与修剪

- (三)链式推理(CoT)生成

- 三、主要功能

- (一)生成高质量医学推理数据

- (二)提升模型性能

- (三)确保医学准确性

- (四)支持多种医学任务

- 四、性能表现

- (一)监督微调(SFT)效果显著

- (二)复杂临床场景表现优异

- 五、应用场景

- (一)医学问答系统

- (二)辅助诊断工具

- (三)医学教育与培训

- (四)医学研究与知识发现

- 六、快速使用

- (一)模型训练

- (二)模型评估

- 1. 模型部署

- 2. 模型评估

- 3. 停止服务

- (三)模型推理

- 七、结语

- 八、项目地址

前言

随着人工智能技术的飞速发展,大型语言模型(LLMs)在各个领域展现出了强大的潜力。然而,在医学领域,由于其对准确性和可靠性的极高要求,如何让LLMs具备精准的医学推理能力成为了一个亟待解决的问题。MedReason项目的出现,为这一挑战提供了一个创新的解决方案。它通过结合知识图谱和链式推理(Chain-of-Thought, CoT),显著提升了LLMs在医学问答和推理任务中的表现。本文将详细介绍MedReason的技术原理、主要功能、性能表现以及应用场景,并通过实际部署案例,展示如何快速使用这一强大的医学推理引擎。

一、项目概述

MedReason是由美国加州大学圣克鲁斯分校(UC Santa Cruz)、加拿大不列颠哥伦比亚大学(University of British Columbia)、新加坡南洋理工大学(Nanyang Technological University)等机构联合推出的一个医学推理数据集。该项目旨在通过知识图谱(Knowledge Graphs)引导的方式,为大型语言模型(LLMs)生成高质量的医学推理步骤,从而提升其在医学领域的推理能力和准确性。MedReason利用结构化的医学知识图谱,将临床问答对转换为逻辑推理链,生成详细的逐步解释,并通过监督微调(SFT)显著提升了模型在多个医学基准测试中的表现,尤其是在复杂临床场景中。其最佳模型MedReason-8B在多个医学问答基准测试中达到了最先进的性能,为医学AI的实际应用提供了重要支持。

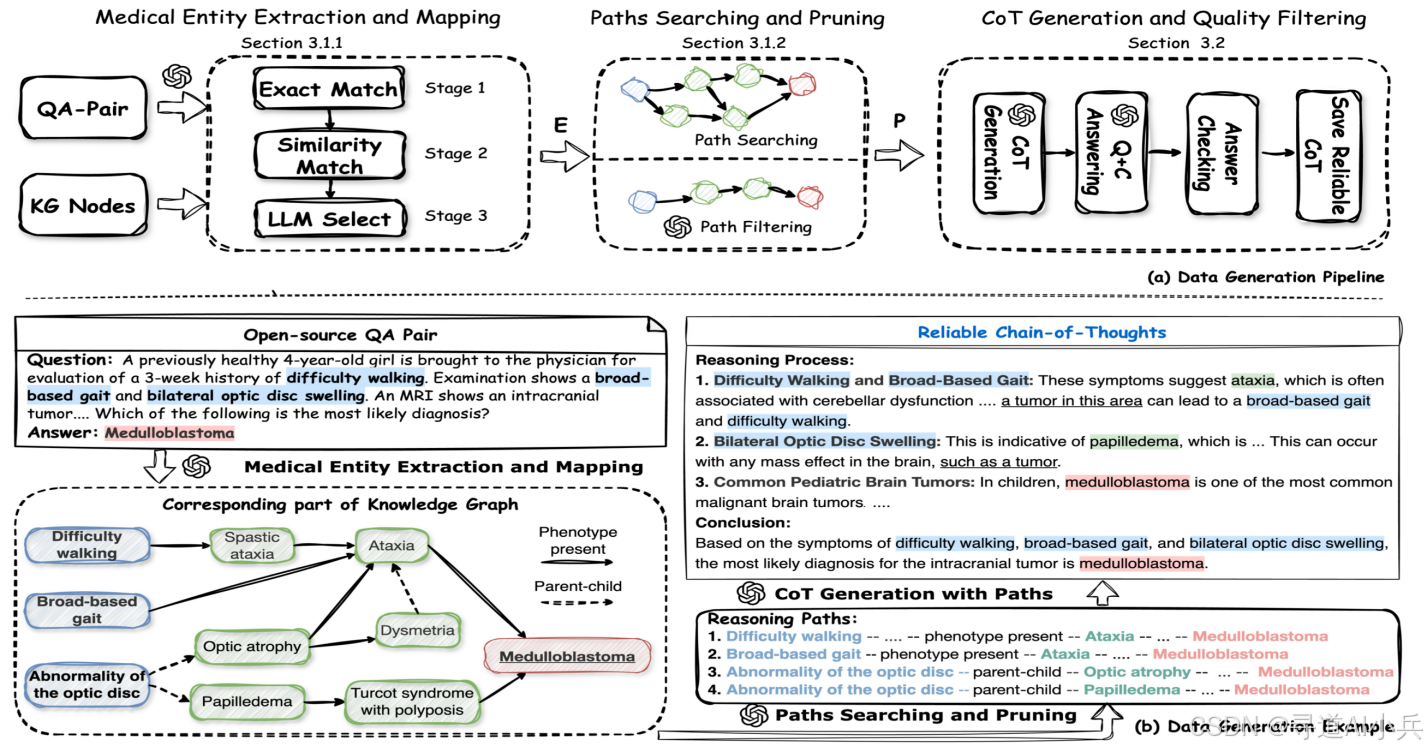

二、技术原理

MedReason的核心技术原理是通过知识图谱(KG)为LLMs的推理过程提供事实基础和逻辑指导。以下是其技术原理的详细解析:

(一)医学实体提取与映射

MedReason首先利用大型语言模型(LLM)从问题和答案中提取医学实体,并将这些实体映射到知识图谱中的节点。这一过程分为三个阶段:

- 文本嵌入与相似度计算:使用文本嵌入模型对每个实体进行编码,并计算其与知识图谱中节点嵌入的相似度,生成候选匹配列表。

- 精确匹配:如果候选列表中存在与实体完全匹配的节点,则直接选择该节点。

- 相似度匹配与LLM选择:如果未找到精确匹配且相似度超过预设阈值(如0.85),则选择最相似的节点;如果仍未找到合适的节点,则由LLM根据上下文和实体名称选择最相关的节点。

(二)路径搜索与修剪

在知识图谱中,MedReason搜索连接问题和答案实体的最短路径,以确保推理路径的简洁性和逻辑性。同时,利用LLM修剪与当前问题无关的路径,保留最相关的推理路径。这一过程不仅确保了推理的逻辑性,还避免了不必要的复杂性。

(三)链式推理(CoT)生成

基于筛选后的推理路径,MedReason指导LLM生成基于医学事实的链式推理(CoT)解释。每一步推理都与知识图谱中的医学知识保持一致,确保推理的准确性和可解释性。此外,MedReason还实施了质量过滤机制,通过验证生成的CoT是否能正确回答问题,系统性地剔除低质量的样本,从而确保数据的高质量。

三、主要功能

MedReason的主要功能是为LLMs生成高质量的医学推理数据,从而提升其在医学领域的推理能力和准确性。具体功能如下:

(一)生成高质量医学推理数据

MedReason能够将临床问答对转换为逻辑推理链,确保每一步推理都有可靠的医学知识支撑。通过知识图谱的引导,生成的推理路径不仅逻辑连贯,而且符合临床逻辑和循证医学原则。

(二)提升模型性能

通过监督微调(SFT),MedReason显著提升了LLMs在医学问答和推理任务中的表现。实验表明,使用MedReason进行微调的模型在多个医学基准测试中表现显著提升,尤其是在复杂临床场景中。

(三)确保医学准确性

MedReason通过专家验证和质量过滤机制,确保生成的推理路径在医学上准确且连贯。此外,其基于知识图谱的生成方式也避免了LLMs常见的“幻觉”问题,确保了推理的可靠性。

(四)支持多种医学任务

MedReason适用于多种医学问答和推理任务,包括诊断、治疗计划和医学知识验证。其生成的推理路径可以为医生提供决策支持,也可以用于医学教育和研究。

四、性能表现

MedReason在多个医学基准测试中的表现显著优于现有的LLMs和医学推理模型。以下是其性能表现的关键点:

(一)监督微调(SFT)效果显著

实验表明,使用MedReason数据进行监督微调的模型在多个医学基准测试中表现显著提升。例如,MedReason-8B在MedBullets基准测试中的表现超过了现有的最先进的医学推理模型Huatuo-o1-8B,平均准确率提升了4.2%。

(二)复杂临床场景表现优异

MedReason在处理复杂临床问题时表现出色。例如,在MedBullets和MedXpert等挑战性基准测试中,MedReason-8B的性能提升尤为显著,分别提升了8.8%和5.2%。这表明MedReason能够有效处理复杂的医学推理任务,为实际临床应用提供了有力支持。

五、应用场景

MedReason的应用场景广泛,涵盖了医学问答系统、辅助诊断工具、医学教育与培训以及医学研究与知识发现等多个领域。以下是具体的应用场景:

(一)医学问答系统

MedReason可以用于开发智能医学问答系统,帮助医生、医学生和患者快速获取准确的医学信息。其生成的详细推理路径可以为用户提供清晰的解释,增强用户对答案的信任度。

(二)辅助诊断工具

在临床实践中,MedReason可以作为辅助诊断工具,帮助医生分析患者的症状和病史,生成可能的诊断建议。通过提供基于医学事实的推理路径,MedReason能够为医生提供决策支持,提高诊断的准确性和效率。

(三)医学教育与培训

MedReason可以用于医学教育和培训,帮助医学生和医学从业者通过实际案例学习复杂的医学推理过程。其生成的推理路径可以作为教学材料,帮助学生更好地理解和掌握医学知识。

(四)医学研究与知识发现

MedReason还可以用于医学研究,帮助研究人员探索新的医学知识和治疗方法。通过分析生成的推理路径,研究人员可以发现潜在的医学关系和知识,为医学研究提供新的思路和方向。

六、快速使用

(一)模型训练

使用 MedReason 数据的简单监督微调 (SFT) 提高了 LLM 的医学推理能力。在 8-GPU 上微调模型:

# based on Huatuo-o1-8B accelerate launch --config_file ./configs/deepspeed_zero3.yaml \ --num_processes 8 \ --num_machines 1 \ --machine_rank 0 \ --deepspeed_multinode_launcher standard ./src/model_training/SFT.py \ --model_path FreedomIntelligence/HuatuoGPT-o1-8B \ --data_path /path/to/your/data \ --n_epochs 3 \ --experiment_name huatuo_o1_medreason_8B \ --base_model Llama # based on DeepSeek-distilled-Llama-8B accelerate launch --config_file ./configs/deepspeed_zero3.yaml \ --num_processes 8 \ --num_machines 1 \ --machine_rank 0 \ --deepspeed_multinode_launcher standard ./src/model_training/SFT.py \ --model_path deepseek-ai/DeepSeek-R1-Distill-Llama-8B \ --data_path /path/to/your/data\ --n_epochs 3 \ --experiment_name distilled_llama_medreason_8B \ --base_model Llama(二)模型评估

1. 模型部署

在开始评估之前,您需要先安装 Sglang。安装完成后,使用以下命令在 8 个 GPU 上部署要测试的模型:

# 部署模型 log_num=0 model_name=UCSC-VLAA/MedReason-8B port=28${log_num}35 CUDA_VISIBLE_DEVICES=0,1,2,3,4,5,6,7 python -m sglang.launch_server \ --model-path $model_name \ --port $port \ --mem-fraction-static 0.8 \ --dp 8 \ --tp 1 > sglang${log_num}.log 2>&1 &部署完成后,模型将准备好进行评估。

2. 模型评估

部署完成后,您可以运行以下代码进行模型评估。我们使用允许模型自由响应的提示,这可以确保提取的结果始终可靠,并广泛涵盖预期范围。如果您需要更精确地提取答案,可以启用更严格的提示(--strict_prompt)。

# 运行评估 log_num=0 task_folder=MedReason-8B-results model_name=UCSC-VLAA/MedReason-8B port=28${log_num}35 eval_file=./eval_data/medbullets_op4.jsonl python ./src/evaluation/eval.py \ --model_name $model_name \ --eval_file $eval_file \ --port $port \ --strict_prompt \ --batch_size 1000 \ --max_new_tokens 2000 \ --task_folder $task_folder3. 停止服务

评估完成后,执行以下命令停止 Sglang 服务并释放 GPU 内存:

# 停止 Sglang 服务 pkill -f sglang pkill -f multiprocessing.spawn

(三)模型推理

以下是一个简单的推理示例,展示如何使用MedReason-8B模型回答医学问题:

from transformers import AutoModelForCausalLM, AutoTokenizer model = AutoModelForCausalLM.from_pretrained('UCSC-VLAA/MedReason-8B',torch_dtype="auto",device_map="auto", use_safetensors= True) model.eval() tokenizer = AutoTokenizer.from_pretrained('UCSC-VLAA/MedReason-8B', trust_remote_code=True, padding_side='left') input_text = "How to stop a cough?" messages = [{"role": "user", "content": input_text}] inputs = tokenizer(tokenizer.apply_chat_template(messages, tokenize=False,add_generation_prompt=True), return_tensors="pt").to(model.device) outputs = model.generate(**inputs, max_new_tokens=2048) print(tokenizer.decode(outputs[0], skip_special_tokens=True))七、结语

MedReason通过结合知识图谱和链式推理,为大型语言模型在医学领域的应用提供了一个创新的解决方案。它不仅显著提升了模型的医学推理能力,还确保了推理过程的准确性和可解释性。MedReason的出现为医学AI的发展带来了新的机遇,也为未来的医学研究和临床应用提供了坚实的基础。

八、项目地址

- GitHub仓库:https://github.com/UCSC-VLAA/MedReason

- HuggingFace模型库:https://huggingface.co/collections/UCSC-VLAA/medreason

- arXiv技术论文:https://arxiv.org/pdf/2504.00993

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索(CSDN博客之星|AIGC领域优质创作者)

📖专属社群:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,回复‘入群’ 即刻上车,获取邀请链接。

💘领取三大专属福利:1️⃣免费赠送AI+编程📚500本,2️⃣AI技术教程副业资料1套,3️⃣DeepSeek资料教程1套🔥(限前500人)

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我们,一起携手同行AI的探索之旅,开启智能时代的大门!