从网页结构到数据提取:Python 爬虫的精准定位

引言

1. 理解爬虫基本原理

1.1 HTTP 请求与响应

2. 网页的基本结构

2.1 HTML标签

3. 网页解析工具

3.1 使用BeautifulSoup

3.1.1 基本用法

3.1.2 CSS选择器

3.2 使用XPath

3.2.1 安装lxml

4. 数据提取实战案例

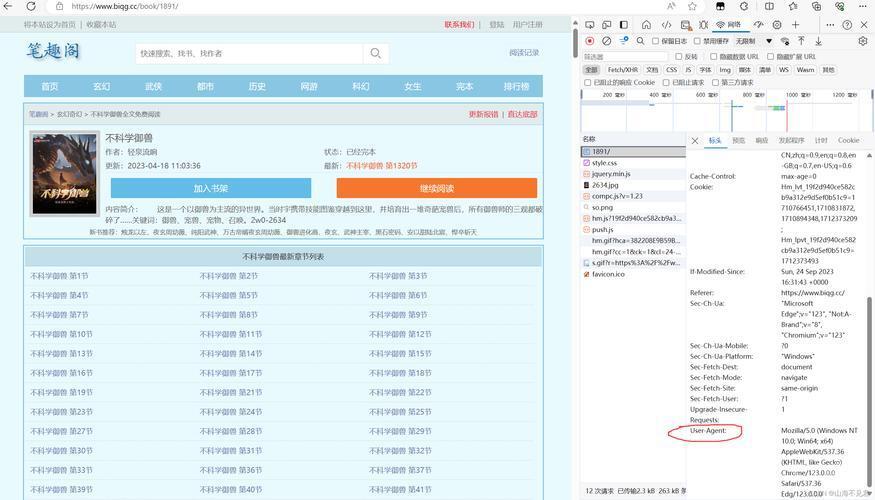

4.1 分析目标网站

4.2 编写爬虫代码

使用BeautifulSoup提取数据

(图片来源网络,侵删)

使用XPath提取数据

5. 动态网页爬取

(图片来源网络,侵删)

5.1 安装Selenium和浏览器驱动

5.2 Selenium示例

(图片来源网络,侵删)

6. 常见问题处理

6.1 反爬机制

6.2 数据存储

结语

引言

在大数据时代,从互联网中提取有用的信息是一项重要的技能。Python爬虫作为一种强大的工具,在数据抓取领域大显身手。在开始我们探索Python爬虫的实战之旅之前,需要对爬虫的基本原理、网页结构和数据提取方法有一个清晰的理解。

1. 理解爬虫基本原理

爬虫的工作核心是模拟浏览器的行为,通过发送HTTP请求获取网页数据,再对网页内容进行解析和提取。

1.1 HTTP 请求与响应

浏览器与服务器通信遵循HTTP协议。当我们打开网页时,浏览器发送一个HTTP请求到服务器,服务器返回一个HTTP响应。响应中包含了HTML、CSS、JavaScript等网页所需的资源。

示例代码:

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。