Linux下如何高效读取和分析日志文件?日志分析怎样又快又准?Linux日志分析如何又快又准?

Linux日志文件的基本位置与分类

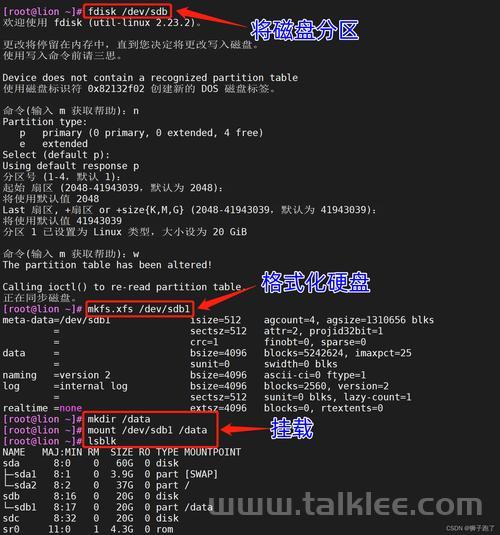

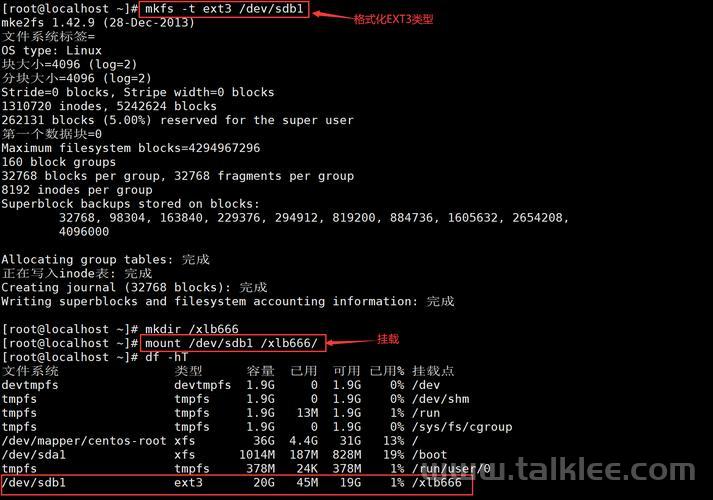

在Linux系统中,日志文件是系统运行状态的重要记录,通常存储在/var/log目录下,这个目录包含了系统运行过程中产生的各类日志记录,不同功能的日志文件各有其特定的用途和存储位置:

核心系统日志

-

系统主日志:

- Debian/Ubuntu系列:

/var/log/syslog - RHEL/CentOS系列:

/var/log/messages

- Debian/Ubuntu系列:

-

认证安全日志:

/var/log/auth.log(记录用户登录、sudo权限操作等安全相关信息)/var/log/secure(RHEL/CentOS系列中的等效文件)

-

内核运行日志:

/var/log/kern.log(记录内核运行时的各种事件和错误)dmesg命令可直接查看内核环形缓冲区内容

-

系统启动日志:

/var/log/boot.log(详细记录系统启动过程中的各个阶段信息)- 现代系统也可使用

journalctl -b查看启动日志

应用程序专用日志

-

Web服务器日志:

- Nginx:

/var/log/nginx/目录下的access.log(访问日志)和error.log(错误日志) - Apache:

/var/log/apache2/(Debian系)或/var/log/httpd/(RHEL系)目录 - 通常包含访问者IP、请求时间、请求方法、响应状态码等信息

- Nginx:

-

数据库日志:

- MySQL/MariaDB:

/var/log/mysql/目录下的error.log等 - PostgreSQL:通常在

/var/log/postgresql/目录 - 包含查询错误、连接问题、性能警告等重要信息

- MySQL/MariaDB:

-

其他服务日志:

/var/log/cron(计划任务执行日志)/var/log/mail.log(邮件服务日志)/var/log/ufw.log(防火墙日志)/var/log/apt/(包管理日志)

发行版差异说明

不同Linux发行版在日志管理上存在一些显著差异:

-

Debian/Ubuntu系列:

- 主要使用

rsyslog作为日志服务 - 配合

journalctl(systemd日志系统)提供更结构化的日志查询 - 默认将大多数系统日志记录到

/var/log/syslog

- 主要使用

-

RHEL/CentOS系列:

- 传统上使用

/var/log/messages作为主系统日志 - 现代版本也全面转向

rsyslog和journalctl的组合 - 安全日志通常记录在

/var/log/secure

- 传统上使用

-

通用趋势:

- 现代Linux系统普遍采用

systemd-journald和rsyslog协同工作 journald提供二进制结构化日志存储rsyslog负责持久化日志到文本文件

- 现代Linux系统普遍采用

命令行日志分析工具详解

基础查看命令

cat 和 less 基础查看

# 查看完整日志内容(适合小文件) cat /var/log/syslog # 分页查看日志(推荐大文件使用) less /var/log/syslog

使用技巧:

- 在

less中,可以按后输入关键词进行搜索,n查找下一个,N查找上一个- 使用

-N参数显示行号:less -N /var/log/syslog- 按

G跳转到文件末尾,gg跳转到文件开头

tail 实时监控

# 查看日志最后100行 tail -n 100 /var/log/nginx/error.log # 实时监控日志更新(调试必备) tail -f /var/log/syslog # 监控多个日志文件 tail -f /var/log/nginx/access.log /var/log/nginx/error.log

高级用法:

tail -f可以配合grep实现过滤监控:tail -f /var/log/syslog | grep "error"- 使用

--retry选项持续尝试打开可能暂时不可用的日志文件- 结合

awk进行实时统计:tail -f access.log | awk '{print $1}' | sort | uniq -c

日志过滤与搜索

grep 精准过滤

# 基本搜索(区分大小写) grep "Failed" /var/log/auth.log # 忽略大小写搜索 grep -i "warning" /var/log/syslog # 显示匹配行及其前后3行内容 grep -C 3 "oom" /var/log/kern.log # 反向搜索(排除包含特定内容的行) grep -v "DEBUG" /var/log/syslog # 统计匹配行数 grep -c "404" /var/log/nginx/access.log # 递归搜索目录下所有日志文件 grep -r "Connection refused" /var/log/

正则表达式高级搜索

# 搜索特定时间段的日志

grep "^Oct 15 1[0-4]:" /var/log/syslog

# 搜索IP地址模式

grep -Eo "[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}" /var/log/nginx/access.log

# 复杂模式匹配(匹配HTTP 5xx错误)

grep -E "HTTP/1.[01]\" 5[0-9]{2}" /var/log/nginx/access.log

# 使用Perl兼容正则(更强大的模式)

grep -P "(\d{1,3}\.){3}\d{1,3}.*?HTTP/\d\.\d\"\s[4-5]\d\d" access.log

高级文本处理

awk 字段提取与分析

# 提取Nginx访问日志中的IP和状态码

awk '{print $1,$9}' /var/log/nginx/access.log

# 统计HTTP状态码出现频率

awk '{print $9}' /var/log/nginx/access.log | sort | uniq -c | sort -nr

# 计算平均响应时间(当日志包含响应时间字段时)

awk '{sum+=$10; count++} END {print "Avg:",sum/count}' /var/log/nginx/access.log

# 统计每个IP的访问量

awk '{ip[$1]++} END {for (i in ip) print i,ip[i]}' access.log | sort -nrk2 | head -20

# 条件过滤与计算

awk '$9 == 404 {print $7}' access.log | sort | uniq -c | sort -nr | head -10

sed 流编辑器

# 删除空白行

sed '/^$/d' /var/log/syslog > cleaned.log

# 替换文本内容

sed 's/error/ERROR/g' /var/log/syslog

# 提取特定时间范围内的日志

sed -n '/Oct 15 10:00:00/,/Oct 15 11:00:00/p' /var/log/syslog

# 只打印匹配行之后的10行

sed -n '/error/{p;n;n;n;n;n;n;n;n;n;n;p;}' syslog

# 多条件处理

sed -e '/warning/d' -e 's/error/CRITICAL/g' syslog > filtered.log

journalctl 系统日志管理

# 查看指定服务的日志 journalctl -u nginx.service # 按时间范围查询 journalctl --since "2023-10-15 09:00:00" --until "2023-10-15 10:00:00" # 按优先级过滤 journalctl -p err..alert # 实时监控新日志 journalctl -f # 查看内核相关日志 journalctl -k # 以JSON格式输出(便于脚本处理) journalctl -o json # 查看特定可执行文件的日志 journalctl /usr/sbin/sshd # 查看指定用户的日志 journalctl _UID=1000 # 显示磁盘使用情况 journalctl --disk-usage # 清理旧日志 journalctl --vacuum-size=500M

专业日志分析工具

日志轮转管理 - logrotate

# 查看全局配置 cat /etc/logrotate.conf # 检查特定服务的配置 cat /etc/logrotate.d/nginx # 手动触发轮转(测试配置) logrotate -d /etc/logrotate.d/nginx # 干跑测试 logrotate -vf /etc/logrotate.d/nginx # 实际执行 # 强制立即轮转所有日志 logrotate -f /etc/logrotate.conf

典型logrotate配置示例:

/var/log/nginx/*.log {

daily

missingok

rotate 14

compress

delaycompress

notifempty

create 0640 www-data adm

sharedscripts

postrotate

if [ -f /var/run/nginx.pid ]; then

kill -USR1 `cat /var/run/nginx.pid`

fi

endscript

}

集中式日志管理方案

ELK Stack (Elasticsearch + Logstash + Kibana)

Logstash配置示例:

input {

file {

path => "/var/log/nginx/access.log"

type => "nginx-access"

start_position => "beginning"

sincedb_path => "/dev/null"

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

geoip {

source => "clientip"

target => "geoip"

}

date {

match => [ "timestamp", "dd/MMM/yyyy:HH:mm:ss Z" ]

locale => "en"

}

useragent {

source => "agent"

target => "useragent"

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "nginx-access-%{+YYYY.MM.dd}"

}

stdout { codec => rubydebug }

}

Grafana Loki

# 使用LogCLI查询Loki中的日志

logcli query '{job="varlogs"} |= "error"'

# 范围查询

logcli query '{job="nginx"} |= "500" |~ "payment"' --limit=100 --since=1h

# 统计错误率

logcli query 'rate({job="nginx"} |~ "5[0-9]{2}" [5m]) by (status_code)'

实时Web日志分析 - GoAccess

# 生成HTML报告 goaccess /var/log/nginx/access.log --log-format=COMBINED -o report.html # 实时监控模式 goaccess /var/log/nginx/access.log --log-format=COMBINED --real-time-html # 指定输出端口 goaccess access.log -o /var/www/html/report.html --real-time-html --port=7890 # 解析特定时间范围的日志 goaccess access.log --log-format=COMBINED --date-format=%d/%b/%Y --time-format=%T \ --ignore-crawlers --keep-last=30 --hour-spec=09-17 -o report.html

日志管理最佳实践

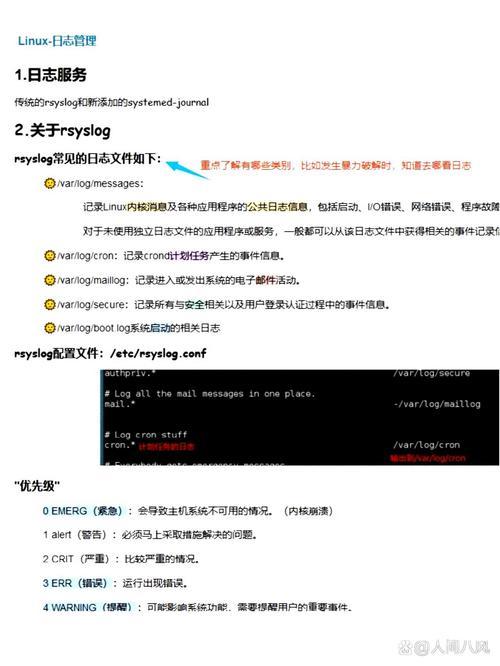

日志分级策略

- debug:详细的调试信息,仅在故障排查时启用

- info:正常的运行时事件(服务启动、配置变更等)

- notice:需要注意但非错误的情况(即将达到阈值等)

- warning:可能有问题的情况(资源使用率高等)

- error:错误事件(功能不可用但系统仍运行)

- crit:关键问题(主要功能受影响)

- alert:需要立即干预(系统即将崩溃)

- emerg:系统不可用(紧急情况)

日志保留策略

# 示例logrotate配置(/etc/logrotate.d/myapp)

/var/log/myapp/*.log {

daily

rotate 30

compress

delaycompress

missingok

notifempty

create 640 appuser adm

sharedscripts

postrotate

/bin/kill -HUP `cat /var/run/myapp.pid 2>/dev/null` 2>/dev/null || true

endscript

}

安全注意事项

-

权限控制:

- 日志文件通常设置为640权限(所有者读写,组读)

- 敏感日志设置为600权限

- 确保日志目录权限为750

-

敏感信息处理:

- 避免记录密码、密钥等敏感信息

- 对信用卡号、身份证号等PII数据进行脱敏

- 考虑使用

logrotate的shred选项安全删除旧日志

-

完整性保护:

- 使用

chattr +a设置只追加属性防止篡改 - 考虑使用

auditd监控关键日志文件的访问

- 使用

性能优化技巧

-

高效搜索:

# 使用zgrep搜索压缩日志 zgrep "error" /var/log/syslog.2.gz # 多条件组合搜索 grep "error" /var/log/syslog | grep -v "connection refused" | awk '{print $5}' -

并行处理:

# 使用parallel并行处理多个日志文件 find /var/log/nginx/ -name "*.log" | parallel -j4 "grep '500' {}" > errors.txt -

高级监控工具:

# 使用multitail同时监控多个日志 multitail -cS apache /var/log/apache2/access.log -cS apache_error /var/log/apache2/error.log # 使用lnav高级日志查看器 lnav /var/log/syslog /var/log/nginx/access.log

进阶日志分析技术

使用Python分析日志

import re

from collections import defaultdict, Counter

import matplotlib.pyplot as plt

def analyze_nginx_log(log_path):

ip_pattern = re.compile(r'\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}')

status_pattern = re.compile(r'HTTP/1.\d" (\d{3})')

error_ips = Counter()

status_codes = Counter()

requests_per_hour = defaultdict(int)

with open(log_path) as f:

for line in f:

# 提取IP

ip_match = ip_pattern.search(line)

if ip_match:

ip = ip_match.group()

# 提取状态码

status_match = status_pattern.search(line)

if status_match:

status = status_match.group(1)

status_codes[status] += 1

# 统计错误IP

if status.startswith('4') or status.startswith('5'):

error_ips[ip] += 1

# 按小时统计请求量

time_part = line.split('[')[1].split(':')[1]

requests_per_hour[time_part] += 1

# 输出结果

print("Top 10 Error IPs:")

for ip, count in error_ips.most_common(10):

print(f"{ip}: {count}")

print("\nHTTP Status Code Distribution:")

for code, count in status_codes.most_common():

print(f"{code}: {count}")

# 绘制请求量趋势图

hours = sorted(requests_per_hour.keys())

counts = [requests_per_hour[h] for h in hours]

plt.plot(hours, counts)

plt.title('Requests per Hour')

plt.xlabel('Hour of Day')

plt.ylabel('Request Count')

plt.show()

if __name__ == "__main__":

analyze_nginx_log('/var/log/nginx/access.log')

机器学习异常检测

-

常见技术栈:

Scikit-learn:常规机器学习算法PyOD:专注于异常检测的库TensorFlow/PyTorch:深度学习方案

-

典型流程:

- 日志解析与特征提取(如日志模板、时序特征等)

- 构建正常行为基线模型

- 实时检测偏离基线的异常模式

- 可视化与告警

-

示例应用:

- 检测异常登录模式

- 识别DDoS攻击特征

- 预测即将发生的磁盘故障

- 发现异常API调用序列

云原生日志方案

-

Fluentd/Fluent Bit:

- 轻量级日志收集器

- 支持多种输入输出插件

- Kubernetes友好

-

Vector:

- 高性能可观测性数据管道

- 比Fluentd更高的吞吐量

- 内置转换和处理能力

-

商业解决方案:

- Splunk:企业级日志分析平台

- Datadog:一体化监控与日志

- Sumo Logic:云原生日志分析

总结与建议

Linux系统提供了丰富的日志管理工具链,从

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。