Linux Poll机制深入分析?Linux Poll机制如何实现高效监控?Poll机制为何高效监控?

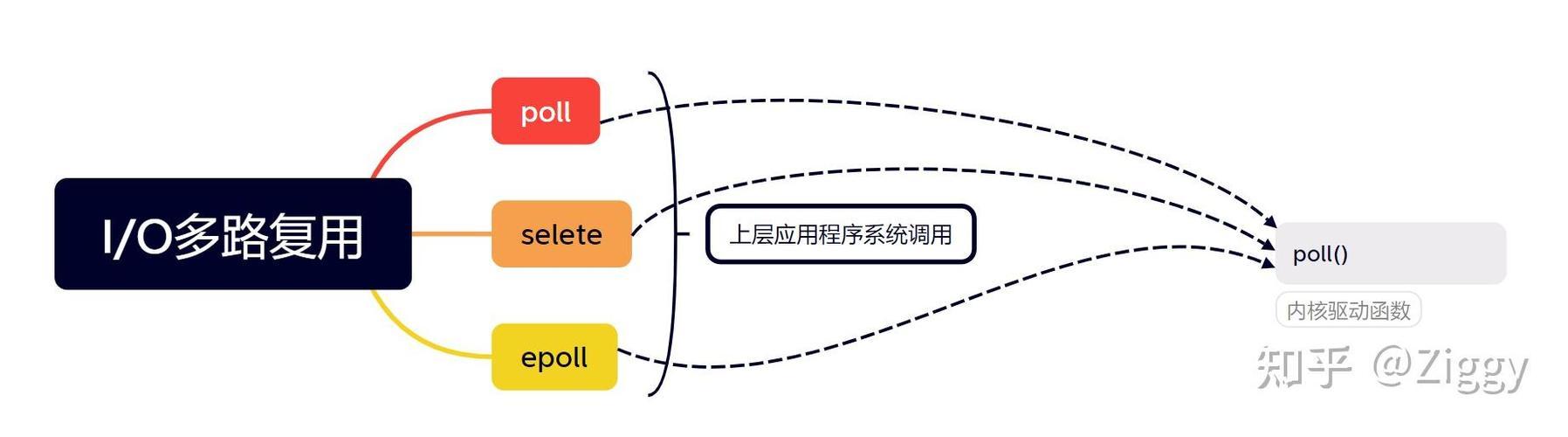

Linux Poll机制是一种高效的文件描述符监控方法,允许应用程序同时监视多个I/O设备的就绪状态,避免轮询带来的性能损耗,其核心通过poll()或epoll()系统调用实现,将监控任务从用户态委托给内核态,由内核触发事件通知。 ,Poll通过维护一个文件描述符集合(pollfd结构数组),监听每个fd的读、写、错误等事件,当调用poll()时,内核会阻塞进程直到至少一个fd就绪,或超时返回,相比select(),Poll没有fd数量限制(仅受系统资源约束),且无需每次重新初始化监控集。 ,高效性体现在三方面: ,1. **减少拷贝开销**:epoll使用红黑树管理fd,通过mmap共享内存避免数据多次拷贝; ,2. **事件驱动**:仅返回就绪的fd,时间复杂度O(1); ,3. **边缘触发(ET)**:epoll支持ET模式,仅在状态变化时通知,进一步降低CPU占用。 ,该机制广泛应用于高并发场景(如Nginx、Redis),是Linux高性能网络编程的关键基础之一。

本文目录

- poll系统调用概述

- poll机制的工作原理

- 内核实现深入分析

- poll与select/epoll的比较

- poll的性能分析与优化

- poll在实际项目中的应用案例

- poll的局限性及替代方案

- 总结与展望

poll系统调用概述

poll的基本概念

poll()是Unix/Linux系统中用于I/O多路复用的核心系统调用之一,它使单个进程能够同时监控多个文件描述符的状态变化,与传统的select()相比,poll()突破了文件描述符数量的硬性限制,采用动态数组结构而非固定大小的位图,为开发者提供了更灵活的I/O管理方式,这种机制特别适合需要同时处理多个I/O通道的中等规模并发场景。

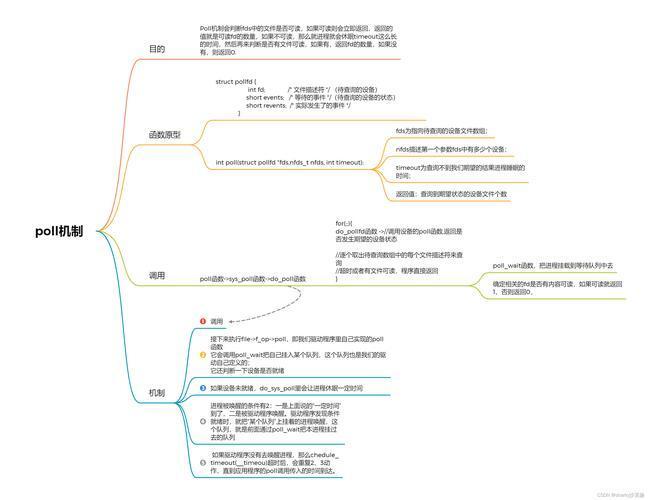

poll系统调用原型

#include <poll.h> int poll(struct pollfd *fds, nfds_t nfds, int timeout);

参数解析:

fds: 指向pollfd结构数组的指针,每个元素对应一个被监控的文件描述符及其关注的事件nfds: 指定监控的文件描述符总数,类型为无符号整型timeout: 超时时间(毫秒),-1表示阻塞等待,0表示非阻塞立即返回,正数表示最大等待时间

pollfd结构定义:

struct pollfd {

int fd; /* 文件描述符 */

short events; /* 监控的事件掩码(输入参数) */

short revents; /* 实际发生的事件掩码(输出参数) */

};

常用事件标志:

POLLIN:数据可读(包括普通数据和优先数据)POLLPRI:高优先级数据可读(如TCP带外数据)POLLOUT:可写不阻塞POLLERR:错误条件(仅在revents中返回)POLLHUP:连接挂起(仅在revents中返回)POLLNVAL:无效请求(文件描述符未打开)

poll机制的工作原理

用户空间与内核空间的交互流程

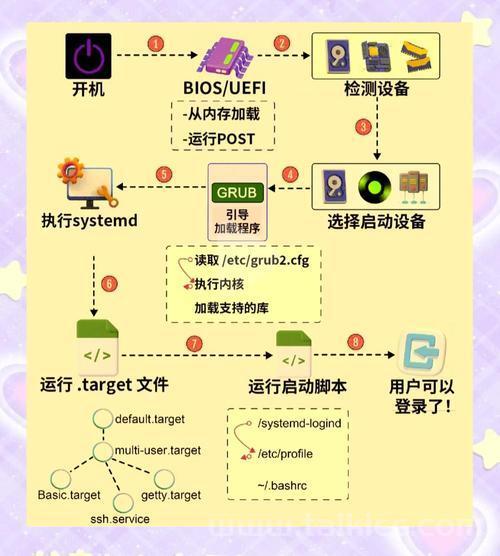

- 系统调用入口:用户进程调用poll()触发软中断,切换到内核态

- 参数验证与复制:内核验证用户空间指针有效性,并将pollfd数组复制到内核空间

- 回调注册:为每个文件描述符注册事件回调函数到对应的设备驱动

- 等待队列操作:将当前进程加入各文件描述符的等待队列(wait queue)

- 初始状态检查:内核立即检查每个文件描述符的当前就绪状态

- 进程调度:若无就绪描述符,当前进程进入可中断睡眠状态(TASK_INTERRUPTIBLE)

- 事件触发唤醒:当任一监控事件发生时,内核唤醒进程并重新检查所有描述符状态

事件触发机制详解

- 硬件中断:当网络接口卡收到数据包或存储设备完成I/O操作时,触发硬件中断

- 驱动处理:设备驱动处理中断,将数据存入内核缓冲区,并更新设备状态

- 唤醒机制:驱动调用

wake_up_interruptible()等函数通知等待队列中的进程 - 状态更新:内核遍历等待队列,更新对应文件描述符的就绪状态标志

- 结果返回:将更新后的revents标记复制回用户空间,并返回就绪的文件描述符数量

超时处理的实现细节

- 高精度定时器:现代Linux内核使用hrtimer(高分辨率定时器)实现纳秒级精度的超时控制

- 双重检查机制:定时器触发后,内核会重新扫描文件描述符以确保没有遗漏事件

- 返回值处理:

- 正值:返回就绪的文件描述符数量

- 0:超时且没有任何事件发生

- -1:发生错误(errno指示具体错误类型)

内核实现深入分析

关键数据结构解析

struct poll_wqueues {

poll_table pt;

struct poll_table_page *table;

struct task_struct *polling_task;

int triggered;

int error;

int inline_index;

struct poll_table_entry inline_entries[N_INLINE_POLL_ENTRIES];

};

struct poll_table_entry {

struct file *filp;

wait_queue_t wait;

wait_queue_head_t *wait_address;

};

poll系统调用完整流程

- 系统调用入口:通过

SYSCALL_DEFINE3(poll,...)宏定义系统调用接口 - 参数验证:使用

copy_from_user()安全地复制用户空间参数 - 内存分配:为poll_table_entry分配空间(优先使用栈内预分配空间)

- 核心循环:

do_poll()函数实现主要处理逻辑:- 初始化等待队列

- 检查当前文件描述符状态

- 设置进程状态为可中断睡眠

- 调用调度器让出CPU

- 文件操作:通过虚拟文件系统(VFS)调用各文件系统实现的poll方法

- 结果处理:统计就绪fd数量,释放资源并返回用户空间

典型文件系统的poll实现

TCP套接字示例:

unsigned int tcp_poll(struct file *file, struct socket *sock, poll_table *wait)

{

struct sock *sk = sock->sk;

unsigned int mask = 0;

sock_poll_wait(file, sk_sleep(sk), wait);

if (sk->sk_state == TCP_LISTEN)

return inet_csk_listen_poll(sk);

if (sk->sk_err || !skb_queue_empty(&sk->sk_error_queue))

mask |= POLLERR;

if (sk->sk_shutdown & RCV_SHUTDOWN)

mask |= POLLRDHUP;

if (!skb_queue_empty(&sk->sk_receive_queue))

mask |= POLLIN | POLLRDNORM;

if (sk->sk_state == TCP_CLOSE)

mask |= POLLHUP;

if (sock_writeable(sk))

mask |= POLLOUT | POLLWRNORM;

return mask;

}

poll与select/epoll的比较

poll vs select对比分析

| 特性 | poll | select |

|---|---|---|

| 数据结构 | 动态数组 | 静态位图 |

| 最大fd数 | 仅受系统资源限制 | FD_SETSIZE(通常1024) |

| 性能特点 | O(n)线性扫描 | O(n)线性扫描 |

| 使用便利性 | 分离events/revents | 每次需重置fd_set |

| 内核实现 | 基于链表结构 | 基于位图操作 |

| 可移植性 | 多数Unix-like系统支持 | 所有Unix系统支持 |

poll vs epoll关键差异

-

数据结构效率:

- poll使用线性数组,每次调用都需要全量扫描所有监控的文件描述符

- epoll使用红黑树管理监控集合,就绪链表维护活跃事件,时间复杂度为O(1)

-

触发模式:

- poll仅支持水平触发(LT)模式,即只要条件满足就会持续通知

- epoll支持边缘触发(ET)和水平触发两种模式,边缘触发只在状态变化时通知一次

-

内存使用:

- poll每次调用都需要从用户空间向内核空间复制完整的监控集合

- epoll在内核维护持久化的事件表,减少了数据拷贝开销

-

适用场景:

- poll适合文件描述符数量较少(几百个)且变化频繁的场景

- epoll适合高并发(数千以上)的长连接场景,如Web服务器

poll的性能分析与优化

性能瓶颈深度分析

- 数据拷贝开销:每次系统调用平均需要拷贝8字节/fd,当监控大量fd时产生显著开销

- CPU缓存效率:线性扫描大数组导致缓存命中率下降,特别是当fd分散在不同设备时

- 唤醒风暴:多个fd同时就绪时可能导致进程被多次不必要地唤醒

- 锁竞争:内核中对等待队列的操作需要获取锁,高并发下可能成为瓶颈

高级优化技巧

- 动态fd管理:

// 优化后的poll循环示例 #define INIT_SIZE 64 #define GROW_FACTOR 2

struct pollfd active_fds = malloc(INIT_SIZE sizeof(struct pollfd)); int current_size = INIT_SIZE;

while(1) { int ret = poll(active_fds, active_count, timeout); // 处理就绪事件...

// 动态调整active_fds大小

if(active_count >= current_size) {

current_size *= GROW_FACTOR;

active_fds = realloc(active_fds, current_size * sizeof(struct pollfd));

}

// 更新监控集合(移除关闭的fd,添加新的fd)

update_monitor_set(active_fds, &active_count);

2. **批处理优化**:

- 合并短时间内的多次poll调用,减少上下文切换开销

- 使用`timerfd`与poll结合实现精确的时间控制

- 对就绪事件进行批量处理,提高缓存利用率

3. **NUMA感知优化**:

- 使用`sched_setaffinity()`绑定处理线程到特定CPU核心

- 为每个NUMA节点分配独立的poll线程和监控集合

- 采用轮询(round-robin)策略分配新连接到不同NUMA节点

## poll在实际项目中的应用案例

### 高性能代理服务器设计

```c

#define MAX_EVENTS 512

struct proxy_context {

struct pollfd fds[MAX_EVENTS];

int fd_count;

struct connection *connections[MAX_EVENTS];

// 其他上下文数据...

};

void event_loop(struct proxy_context *ctx) {

while(1) {

int ready = poll(ctx->fds, ctx->fd_count, -1);

if (ready == -1) {

if (errno == EINTR) continue;

perror("poll");

break;

}

for(int i=0; i<ctx->fd_count && ready>0; i++) {

if(ctx->fds[i].revents) {

handle_event(ctx, i);

ready--;

// 处理过程中可能修改监控集合

if (i < ctx->fd_count-1) {

// 如果后面还有fd需要检查,且当前fd被移除

// 需要调整循环索引

if (ctx->fds[i].fd == -1) i--;

}

}

}

// 动态更新监控集合

update_monitor_set(ctx);

}

}工业控制系统中的实时应用

-

多设备监控架构:

- 同时监视PLC控制器、传感器阵列、HMI界面等多个设备接口

- 为不同类型的I/O设备设置优先级队列

- 使用

SCHED_FIFO实时调度策略确保关键事件及时响应

-

确定性响应实现:

- 结合RT-Preempt补丁实现微秒级响应延迟

- 为关键路径禁用内核抢占和中断

- 使用内存锁定(mlock)防止页面交换引入的延迟

-

故障恢复机制:

- 通过

POLLERR和POLLHUP事件检测设备异常 - 实现自动重连和状态恢复逻辑

- 记录详细的事件日志用于事后分析

- 通过

poll的局限性及替代方案

现代架构下的挑战

- 多核扩展性问题:单线程poll模型难以充分利用多核CPU,而多线程poll又面临同步开销

- 云原生适配问题:在容器化环境中,poll与cgroup、namespace等新特性的集成不够优化

- 新硬件支持不足:无法充分利用现代网卡的多队列、RSS(接收侧扩展)等特性

- 能效比问题:在移动设备和边缘计算场景下,频繁唤醒CPU导致能耗增加

替代方案选型指南

| 场景特征 | 推荐方案 | 原因说明 |

|---|---|---|

| 跨平台需求 | poll | POSIX标准,移植性最好 |

| 高并发长连接 | epoll | O(1)复杂度,内核事件表 |

| 超低延迟 | io_uring | 零拷贝,完全异步,高吞吐 |

| Windows平台 | IOCP | 原生支持完成端口 |

| 多核扩展性需求 | 多线程+epoll | 每个线程独立epoll实例 |

| 批处理型I/O | 异步I/O | 减少系统调用次数 |

poll机制作为Linux I/O多路复用的重要组成部分,其设计思想影响了后续多种I/O模型的发展,尽管在高并发场景下逐渐被epoll取代,poll在以下场景仍具独特优势:

- 嵌入式系统:资源受限环境下的轻量级解决方案,代码 footprint 小

- 兼容性要求:需要跨多种Unix-like系统移植的应用程序

- 简单监控场景:只需监控少量文件描述符的应用程序

- 实时系统:与RT-Preempt等实时扩展配合良好的确定性响应

未来发展趋势:

- 与io_uring集成:结合Linux 5.1引入的新型异步I/O接口,实现混合监控模式

- 硬件加速:利用SmartNIC(智能网卡)卸载poll事件处理,减少CPU开销

- 混合监控模型:在同一个应用中针对不同I/O类型混合使用poll/epoll/io_uring

- 安全增强:结合BPF(Berkeley Packet Filter)实现细粒度的I/O事件过滤

理解poll的底层实现不仅有助于编写高效网络程序,更是深入理解Linux内核设计哲学的重要途径,开发者应当根据具体应用场景,在传统可靠性与现代高性能之间做出合理权衡,选择最适合的I/O多路复用方案。

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。