Linux分片解压,高效处理大型压缩文件的技巧与方法?分片解压Linux大文件?Linux大文件如何分片解压?

在Linux系统中,高效处理大型压缩文件的分片解压可通过以下技巧实现: ,1. **分卷压缩文件解压** , 若文件已按分卷压缩(如file.zip.001、file.zip.002),使用zip或7z工具合并后解压: , ``bash , zip -s 0 file.zip --out merged.zip && unzip merged.zip , 或 , 7z x file.zip.001 # 自动识别后续分卷 ,`,2. **按需解压部分内容** , 通过tar或unzip提取特定文件,避免全量解压: ,`bash , tar -xzvf large_file.tar.gz path/to/extract , unzip large_file.zip "target_dir/*" ,`,3. **并行加速解压** , 结合pigz(多线程gzip)或pbzip2提升速度: ,`bash , tar -I pigz -xvf file.tar.gz ,`,4. **流式处理大文件** , 使用管道边解压边处理(如zcat file.gz | grep "pattern"`),减少磁盘占用。 ,***:分片解压需根据压缩格式选择工具,灵活运用合并、部分解压及多线程命令,可显著提升效率并节省资源。

目录

在Linux系统管理中,处理大型压缩文件是一项关键技能,当面对数十GB甚至TB级别的数据备份、软件分发或批量文件传输时,传统的单文件压缩方式往往效率低下且风险较高,分片压缩技术通过将大文件分割为多个小文件,不仅提高了传输可靠性,还能充分利用现代多核处理器的并行计算能力。

本文将全面剖析Linux环境下分片解压的技术细节,从基础原理到高级应用,涵盖多种工具和场景,帮助您掌握高效处理分片压缩文件的完整解决方案。

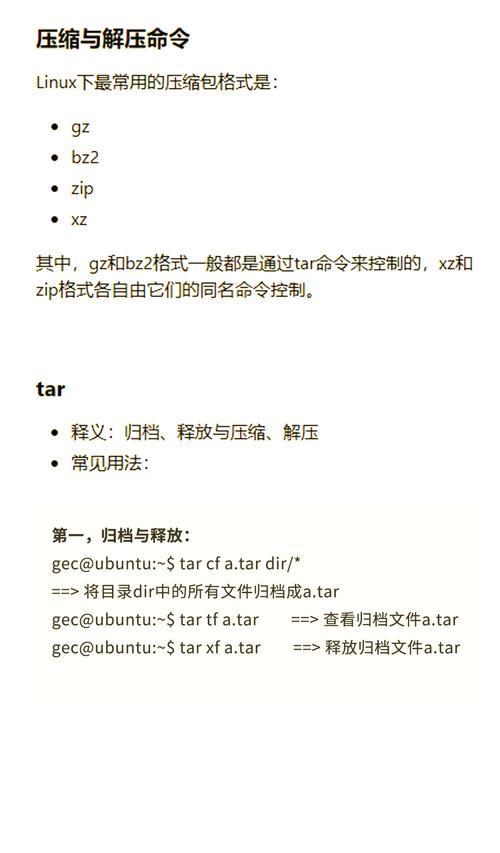

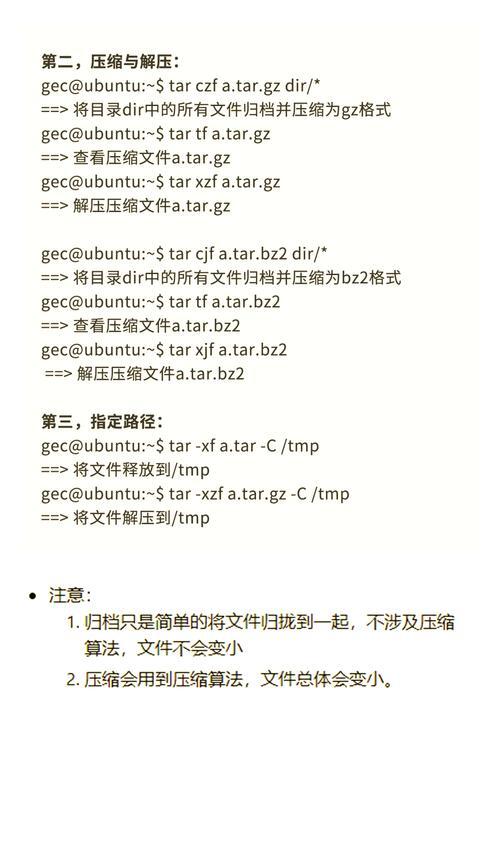

分片压缩与解压的核心概念

分片压缩技术的深度解析

分片压缩(Split Archiving)是一种将单个大文件智能分割为多个较小体积文件的技术方案,它解决了大数据处理的四个关键问题:

- 传输稳定性:在网络传输场景中,小文件传输失败率显著降低,且支持断点续传机制

- 存储兼容性:突破传统文件系统(如FAT32)对单个文件4GB大小的限制

- 管理灵活性:支持选择性下载或传输特定分片,实现增量更新和部分恢复

- 处理并行化:多个分片可同时进行传输或解压操作,大幅提升整体吞吐量

主流分片压缩格式对比分析

| 格式类型 | 典型文件扩展名 | 核心优势 | 适用场景 |

|---|---|---|---|

| TAR+GZIP | .tar.gz.001, .tar.gz.002 | Linux原生支持,压缩率高 | 服务器备份、日志归档 |

| ZIP分卷 | .zip.001, .zip.002 | 跨平台兼容性最佳 | 跨系统文件交换 |

| 7z分片 | .7z.001, .7z.002 | LZMA2算法提供超高压缩率 | 需要极致压缩比的场景 |

| RAR分卷 | .part1.rar, .part2.rar | 完善的错误恢复功能 | Windows环境数据分发 |

分片解压的技术实现原理

分片解压过程本质上是将分散的文件分片重新组合为原始压缩包,然后进行常规解压操作,其核心技术要点包括:

- 分片智能识别:通过文件命名规则(如连续编号、固定前缀)自动关联相关分片

- 顺序精确重组:严格按照原始分割顺序进行二进制合并,确保数据完整性

- 完整性验证:通过校验和(如MD5、SHA256)检查分片是否完整且未被篡改

- 资源优化管理:采用流式处理技术降低大文件合并时的内存消耗

Linux分片解压的主流方法

基础方法:使用cat命令合并解压

这是最通用可靠的方法,适用于几乎所有分片类型:

# 合并所有分片(确保磁盘空间充足) cat archive.tar.gz.* > complete_archive.tar.gz # 验证合并文件完整性(可选但推荐) sha256sum complete_archive.tar.gz | diff - checksum.sha256 # 解压合并后的文件 tar -xzvf complete_archive.tar.gz -C /target/directory

关键注意事项:

- 所有分片必须位于同一目录且命名规则一致

- 使用

ls -v命令确认分片排序正确 - 合并大文件时需要2倍于原文件的临时存储空间

高效方法:直接解压分片TAR文件

现代GNU tar(1.30+)支持智能识别分片序列:

# 自动识别后续分片(.002, .003等) tar -xzvf multi_part.tar.gz.001 --checkpoint=.1000 # 显示详细解压进度 tar -xzvf large_file.tar.gz.001 | pv -petra > /dev/null

技术优势:

- 流式处理避免临时文件存储

- 自动校验分片连续性

- 支持进度监控和断点续解

专业工具:7z处理复杂分片

7-Zip是处理各类分片压缩的瑞士军刀:

# 解压加密分片压缩包 7z x -p"SecurePassword123!" secret_data.7z.001 -o/extract/path # 多线程加速解压(适用于多核CPU) 7z x -mmt=8 large_file.7z.001 # 测试分片完整性而不解压 7z t -r damaged_archive.7z.001

7z高级参数:

-r:递归处理损坏分片尝试修复-scrc:强制校验文件CRC值-y:自动应答所有提示(适用于脚本)

极致性能:并行化处理方案

针对超大规模文件(50GB+)的优化方案:

# 使用GNU parallel实现并行合并解压

parallel -j 4 'cat {}' ::: archive.tar.gz.* | tar -xzvf - --use-compress-program=pigz

# 分布式解压方案(需SSH免密登录)

for node in {1..4}; do

ssh node$node "cat /shared/archive.tar.gz.$node"

done | tar -xzvf - -C /cluster/storage

实战操作案例解析

案例1:企业级数据库备份恢复

场景:解压生产环境MySQL分片备份db_backup.2023.tar.gz.00[1-5]

# 创建专用恢复目录

mkdir -p /restore/mysql && cd /restore/mysql

# 验证分片完整性

for part in db_backup.2023.tar.gz.*; do

gzip -t $part || echo "$part 损坏!需重新传输"

done

# 流式解压避免磁盘写满

cat db_backup.2023.tar.gz.* | \

tar -xzvf - --exclude='*.tmp' --checkpoint-action=echo="已解压%d MB"

案例2:处理科研机构大型数据集

场景:解压加密的基因组数据genome_data.7z.00[1-10]

# 使用内存盘加速解压

sudo mount -t tmpfs -o size=20G tmpfs /mnt/ramdisk

# 并行解压到内存盘

7z x -pGen0m3@2023 -mmt=4 -o/mnt/ramdisk genome_data.7z.001

# 验证关键文件

find /mnt/ramdisk -name "*.fastq" -exec md5sum {} + > checksums.txt

案例3:跨平台影视素材处理

场景:解压Windows创建的4K视频素材video_project.zip.00[1-8]

# 方法1:使用zip自带合并功能 zip -FF video_project.zip --out complete_video.zip && \ unzip complete_video.zip -d /media/4k_footage # 方法2:直接合并二进制文件 cat video_project.z* > full_video.zip && \ unzip full_video.zip

常见问题排查与解决方案

分片顺序异常问题

典型症状:

- 解压时报"Unexpected end of file"错误

- 提示"Missing volume"或"Part number mismatch"

智能修复方案:

# 自动重命名错乱的分片文件

ls -1v *.part* | awk -F. '{printf "mv -n %s %04d.%s\n", $0, NR, $NF}' | bash

# 重建正确的分片序列

reconstruct_archive() {

base_name=${1%.*}

cat $(ls -1v ${base_name}.*) > reconstructed_${base_name}

file reconstructed_${base_name}

}

分片损坏处理流程

完整性验证技术:

# 创建分片校验基准文件

for part in archive.*; do

echo "$(cksum $part) $(stat -c%s $part)" >> parts.cksum

done

# 自动化验证脚本

validate_parts() {

while read ck sz file; do

current=$(cksum "$file" | awk '{print $1,$2}')

[ "$current" = "$ck $sz" ] || echo "$file 校验失败"

done < parts.cksum

}

高级恢复技术:

- 使用par2创建恢复卷:

par2 create -r10 -n5 archive.tar.gz.*

- 7z内置修复功能:

7z r -ir'!*.7z.001' damaged_archive.7z.001

存储空间不足的解决方案

创新性处理方案:

# 方案1:网络流式解压 ssh data_server "cat /remote/archive.tar.gz.*" | tar -xzvf - -C /local/target # 方案2:使用FUSE虚拟文件系统 archivefs archive.tar.gz.001 /mnt/virtual_archive # 方案3:分阶段解压 tar -xzvf archive.tar.gz.001 --exclude="*.mp4" && \ tar -xzvf archive.tar.gz.001 --wildcards "*.mp4"

高级技巧与最佳实践

企业级解压工作流

-

预处理阶段:

# 创建隔离环境 mktemp -d /tmp/unpack_XXXXXX && cd $_ # 安全验证 gpg --verify archive.sig archive.001 || exit 1

-

核心解压阶段:

# 资源监控下的解压 /usr/bin/time -v tar -xzvf archive.001 --use-compress-program='pigz -p 8'

-

后处理阶段:

# 自动清理和归档 find . -type f -mtime +1 -exec rm -v {} \; && \ zip -r processed_$(date +%F).zip extracted_content

云原生解压方案

AWS S3集成示例:

# 直接从S3流式解压

aws s3 cp s3://data-bucket/large.tar.gz.001 - | \

tee >(sha256sum > s3_checksum) | \

tar -xzvf - --directory /efs/mount

# 验证云端传输完整性

diff s3_checksum original.sha256 && echo "验证通过"

Kubernetes批处理方案:

apiVersion: batch/v1

kind: Job

metadata:

name: parallel-unpack

spec:

parallelism: 4

template:

spec:

containers:

- name: unpacker

image: alpine:latest

command: ["sh", "-c"]

args:

- "apk add tar pigz &&

cat /data/archive.tar.gz.$((JOB_COMPLETION_INDEX+1)) |

tar -xzvf - -C /output"]

安全加固措施

-

沙箱解压环境:

# 使用Firejail创建隔离环境 firejail --private --net=none tar -xzvf untrusted_archive.001

-

自动化安全扫描:

# 结合ClamAV进行病毒扫描 tar -xzvf archive.001 --to-command='clamdscan - --no-summary'

-

权限最小化原则:

# 使用非特权用户解压 sudo -u safeuser -- tar -xzvf archive.001 --no-same-owner

通过掌握这些Linux分片解压技术,您将能够从容应对从个人电脑到企业级数据中心的各种大规模数据处理需求,显著提升工作效率并降低系统资源消耗,无论是常规运维还是紧急恢复,都能确保数据处理的可靠性和时效性。