Python 爬虫实战:如何爬取小红书数据并进行分析

一、引言

随着社交电商的崛起,小红书(Xiaohongshu)作为一款结合了社交和电商的应用,吸引了大量年轻用户。用户在平台上分享购物心得、生活经验以及个性化的消费推荐内容,形成了庞大的用户数据与内容生态。因此,如何从小红书获取数据进行分析,成为了数据科学、市场营销和社交媒体研究中的一个重要课题。

本文将介绍如何使用 Python 编写爬虫爬取小红书的数据,分析如何通过小红书的开放 API 获取用户信息、帖子内容、评论、点赞等信息,并结合数据分析和可视化来提取有价值的商业和社交信息。

二、爬虫基础

2.1 什么是爬虫?

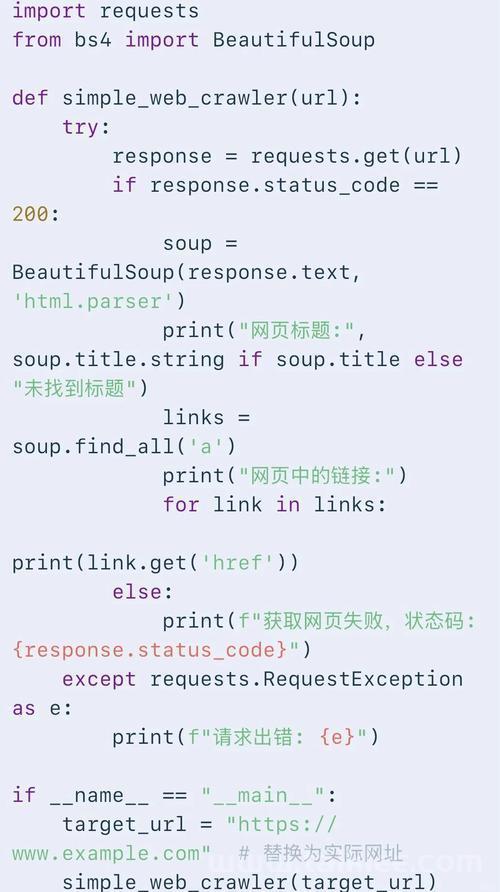

爬虫(Crawler),也叫网络蜘蛛,是一种自动化程序,用来从互联网上抓取数据。爬虫主要由以下几个模块组成:

- 请求模块:模拟浏览器请求网页或 API 接口,获取数据。

- 解析模块:对获取的数据进行解析,提取出我们需要的信息。

- 存储模块:将提取出来的数据保存到数据库或本地文件中。

- 数据分析与可视化:对抓取的数据进行清洗、分析和可视化,得出有价值的信息

(图片来源网络,侵删)

(图片来源网络,侵删)

(图片来源网络,侵删)

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。