Python 在 Web 爬虫反爬策略中的最新应对方法

```html Python 在 Web 爬虫反爬策略中的最新应对方法

Python 在 Web 爬虫反爬策略中的最新应对方法

随着互联网的快速发展,数据已经成为企业决策和产品优化的重要依据。然而,许多网站为了保护其内容和服务,采取了各种反爬虫策略。这些策略使得传统的网络爬虫难以高效地获取数据。本文将探讨 Python 在面对这些反爬虫策略时的最新应对方法。

了解反爬虫策略

反爬虫策略通常包括但不限于以下几种:

- IP 限制:限制单个 IP 地址在一定时间内的访问次数。

- User-Agent 检测:通过检查请求头中的 User-Agent 字段来判断是否为爬虫。

- Captcha 验证:要求用户完成验证码验证才能继续访问。

- 动态加载:使用 JavaScript 动态生成内容,增加爬取难度。

了解这些策略是成功应对它们的前提。

使用高级代理池

为了绕过 IP 限制,可以使用代理池技术。代理池是一个包含多个代理服务器的集合,每次请求时从池中随机选择一个代理。这样可以有效避免因频繁请求而被封禁。

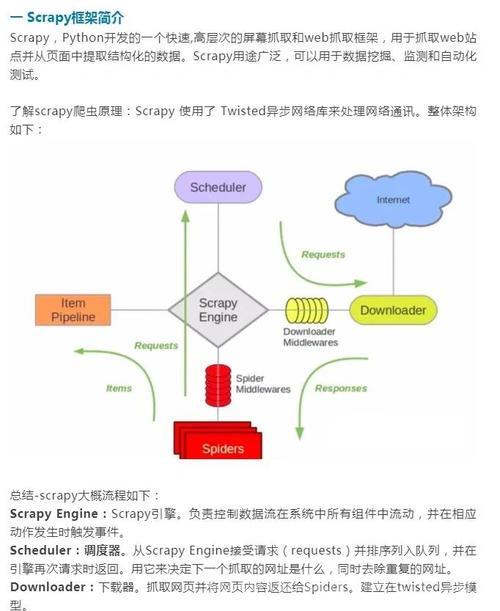

在 Python 中,可以使用 Scrapy 框架结合 RotatingProxyPool 来实现这一功能。Scrapy 是一个强大的爬虫框架,支持多种扩展插件,能够轻松管理代理池。

import random PROXY_POOL = [ 'http://proxy1.example.com:8080', 'http://proxy2.example.com:8080', 'http://proxy3.example.com:8080' ] def get_random_proxy(): return random.choice(PROXY_POOL)模拟真实浏览器行为

许多网站会检测 User-Agent 字段以识别爬虫。因此,模拟真实浏览器的行为显得尤为重要。可以通过设置请求头中的 User-Agent 字段来实现这一点。

在 Python 中,可以使用 requests 库来定制请求头。例如:

import requests headers = { 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3' } response = requests.get('https://example.com', headers=headers)此外,还可以结合 Selenium 或 Playwright 等工具,这些工具可以模拟完整的浏览器行为,包括点击按钮、填写表单等操作。

处理动态加载内容

一些网站使用 JavaScript 动态加载内容,这给爬虫带来了额外的挑战。为了解决这个问题,可以使用 headless 浏览器(如 Puppeteer)来执行 JavaScript 并渲染页面。

在 Python 中,可以使用 Playwright 库来实现这一功能。Playwright 提供了强大的 API,允许开发者控制浏览器的行为。

from playwright.sync_api import sync_playwright with sync_playwright() as p: browser = p.chromium.launch(headless=True) page = browser.new_page() page.goto('https://example.com') content = page.content() browser.close()总结

面对日益复杂的反爬虫策略,Python 提供了多种解决方案。通过使用代理池、模拟真实浏览器行为以及处理动态加载内容,可以有效地应对这些挑战。当然,合法合规地进行数据采集始终是最重要的原则。

希望本文能帮助读者更好地理解和应用这些技术,从而更高效地完成网络爬虫任务。

```

(图片来源网络,侵删)(图片来源网络,侵删)(图片来源网络,侵删)