如何优化和管理Linux内存?Linux内存怎么优化才高效?Linux内存优化有诀窍?

优化和管理Linux内存需结合系统监控与配置调整,使用free、top等命令实时监控内存使用情况,识别高占用进程,通过调整swappiness值(默认60,建议降低至10-30)减少交换分区依赖,提升响应速度;使用vm.vfs_cache_pressure参数控制缓存回收频率(如设为50),对大内存服务器,启用HugePages可减少TLB开销,而定期清理缓存(sync; echo 3 > /proc/sys/vm/drop_caches)可释放临时内存,优化应用程序代码、限制服务资源(如cgroups)及升级内核也能有效提升效率,长期运行的系统建议配置日志轮转和OOM Killer策略,综合平衡性能与稳定性。

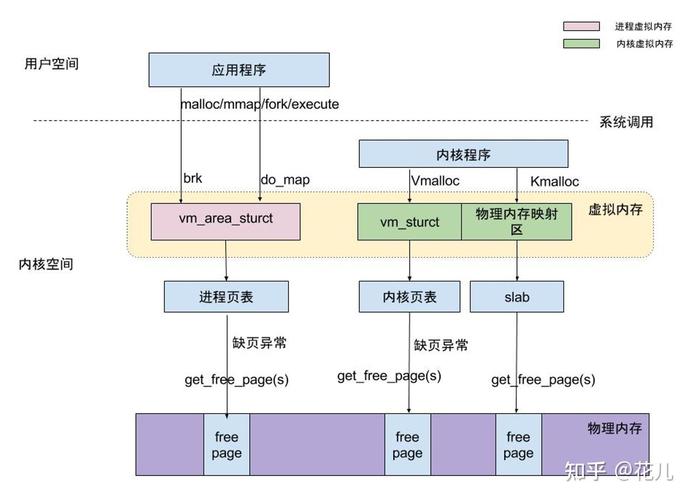

Linux内存管理基础原理

物理内存与虚拟内存机制

Linux操作系统采用分层式内存架构,将物理内存(RAM)与虚拟内存(交换空间,Swap)有机结合,构建高效的内存管理体系,物理内存作为计算机的核心高速存储介质,其访问速度可达纳秒级,但容量通常有限;而虚拟内存则利用磁盘空间扩展可用内存,通过交换技术实现内存的动态扩展。

-

物理内存特性:

- 直接与CPU相连,提供极低延迟的数据访问

- 易失性存储,断电后数据丢失

- 现代服务器通常配置32GB-1TB不等

-

虚拟内存优势:

- 突破物理内存容量限制

- 实现内存隔离,增强系统安全性

- 支持内存超量分配(Overcommit)

现代内存分配机制详解

Linux内核采用先进的内存管理技术确保资源高效利用:

-

分页管理:

- 默认页大小为4KB(支持2MB/1GB大页)

- 多级页表实现快速地址转换

- TLB缓存加速地址转换过程

-

交换策略演进:

- 传统交换:整进程内存映像交换(效率低)

- 现代页面交换:按需交换内存页(4KB粒度)

- 压缩交换:Zswap/Zram技术减少I/O压力

智能缓存体系剖析

Linux通过多级缓存大幅提升系统性能:

graph LR

A[CPU Cache] --> B[Page Cache]

B --> C[Buffer Cache]

C --> D[Disk Storage]

-

页面缓存(Page Cache):

- 缓存文件内容,加速重复读取

- 采用LRU算法管理缓存项

- 可配置的脏页回写策略

-

缓冲区(Buffer Cache):

- 优化块设备I/O操作

- 减少磁盘碎片产生

- 合并小写入提升吞吐量

全方位内存监控技术

free命令深度解析

free -h输出示例与关键指标:

total used free shared buff/cache available Mem: 62G 15G 2.3G 1.2G 44G 45G Swap: 32G 0B 32G

指标解读技巧:

- available:包含可立即回收的缓存,比free更准确

- buff/cache:当应用程序需要内存时可快速回收

- swap使用:长期高于10%需引起警惕

实时监控工具进阶用法

htop增强功能展示:

- 树状视图显示进程关系

- 颜色区分不同资源状态

- 支持鼠标交互操作

- 可定制显示列和排序

关键指标关联分析:

- VIRT高但RES低:可能存在内存泄漏

- SHR异常增长:检查共享库使用情况

- SWAP列:显示各进程交换使用量

vmstat专业分析方法

典型生产环境输出模式分析:

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu----- r b swpd free buff cache si so bi bo in cs us sy id wa st 2 0 1048576 524288 262144 4194304 1024 2048 4096 8192 5000 8000 20 10 65 5 0

性能瓶颈诊断:

- wa值持续>5%:I/O等待过高

- si/so持续非零:内存压力大

- cs值过高:进程切换频繁

/proc/meminfo关键指标

生产环境重点关注:

MemTotal: 65892104 kB MemFree: 2378448 kB MemAvailable: 47234560 kB Active: 29456720 kB Inactive: 21567840 kB Dirty: 1024 kB Writeback: 0 kB AnonPages: 18432000 kB Mapped: 5242880 kB Shmem: 10485760 kB Slab: 4194304 kB SReclaimable: 3145728 kB SUnreclaim: 1048576 kB PageTables: 524288 kB CommitLimit: 66273280 kB Committed_AS: 58720256 kB

异常检测标准:

- Dirty > 10%内存:存储性能瓶颈

- SUnreclaim持续增长:内核内存泄漏

- Committed_AS接近CommitLimit:OOM风险

内存优化高级实践

Swappiness智能调优

不同场景推荐配置:

| 场景类型 | swappiness值 | 备注 |

|---|---|---|

| 数据库服务器 | 1-10 | 避免关键数据被交换 |

| Java应用服务器 | 10-30 | 平衡GC与交换需求 |

| 桌面环境 | 30-60 | 保证交互响应 |

| 内存<4GB | 5-15 | 减少交换抖动 |

动态调整脚本示例:

#!/bin/bash

# 根据内存压力自动调整swappiness

MEMAVAIL=$(grep MemAvailable /proc/meminfo | awk '{print $2}')

TOTALMEM=$(grep MemTotal /proc/meminfo | awk '{print $2}')

RATIO=$((100*MEMAVAIL/TOTALMEM))

if [ $RATIO -lt 10 ]; then

echo 30 > /proc/sys/vm/swappiness

elif [ $RATIO -lt 20 ]; then

echo 20 > /proc/sys/vm/swappiness

else

echo 10 > /proc/sys/vm/swappiness

fi

缓存管理黄金法则

生产环境缓存清理策略:

- 避免常规性手动清理

- 优先调整应用内存使用模式

- 必要时分级清理:

# 仅清理页面缓存(最安全) echo 1 > /proc/sys/vm/drop_caches # 清理目录项和inode(文件密集型适用) echo 2 > /proc/sys/vm/drop_caches # 全量清理(慎用) sync && echo 3 > /proc/sys/vm/drop_caches

自动缓存调节机制:

# 调整脏页比例(默认20%) echo 10 > /proc/sys/vm/dirty_ratio # 设置脏页回写阈值(默认10%) echo 5 > /proc/sys/vm/dirty_background_ratio # 控制脏页存活时间(秒) echo 300 > /proc/sys/vm/dirty_expire_centisecs

内存压缩技术对比

Zswap与Zram技术矩阵:

| 特性 | Zswap | Zram |

|---|---|---|

| 工作原理 | Swap前端缓存 | 内存中的压缩块设备 |

| 压缩对象 | 换出页面 | 所有交换数据 |

| 内存使用 | 动态调整 | 固定大小 |

| 适用场景 | 通用服务器环境 | 内存受限设备/容器环境 |

| 推荐配置 | 与Swap配合使用 | 替代传统Swap |

| 性能影响 | 中等CPU开销 | 较高CPU开销 |

生产环境配置示例:

# Zswap配置(内核参数) echo 1 > /sys/module/zswap/parameters/enabled echo lz4 > /sys/module/zswap/parameters/compressor echo zsmalloc > /sys/module/zswap/parameters/zpool # Zram配置(4个设备,各4GB) modprobe zram num_devices=4 echo lz4 > /sys/block/zram0/comp_algorithm echo 4G > /sys/block/zram0/disksize mkswap /dev/zram0 swapon /dev/zram0

生产环境问题诊断

内存泄漏排查流程

系统级检查清单:

- 持续监控

/proc/meminfo中的Slab和SUnreclaim - 使用

slabtop分析内核对象分配 - 检查

/proc/<pid>/smaps分析进程内存映射 - 通过

strace追踪异常内存分配

Java应用专项检查:

# 生成堆转储 jmap -dump:format=b,file=heap.hprof <pid> # 统计对象分布 jmap -histo <pid> | head -20 # 启用Native内存跟踪 export JAVA_OPTS="-XX:NativeMemoryTracking=detail" jcmd <pid> VM.native_memory detail

OOM防御体系构建

多级防护策略:

-

预警层:

- 部署

earlyoom服务 - 配置

/proc/sys/vm/panic_on_oom=0

- 部署

-

控制层:

# 保护关键进程 echo -1000 > /proc/<pid>/oom_score_adj # 限制用户内存 ulimit -v 500000

-

应急层:

# 快速创建应急Swap文件 dd if=/dev/zero of=/emergency.swap bs=1M count=2048 chmod 600 /emergency.swap mkswap /emergency.swap swapon /emergency.swap

OOM日志分析模板:

[Wed Jul 15 03:45:12 2023] Out of memory: Kill process 21534 (java) score 998

[Wed Jul 15 03:45:12 2023] Memory cgroup stats for /system.slice/docker.service:

cache:1024KB rss:16GB rss_huge:0KB shmem:1024KB mapped_file:512KB

swap:2GB inactive_anon:8GB active_anon:8GB inactive_file:512KB

active_file:512KB unevictable:0KB分析要点:

- 触发时的内存分布

- 被杀进程类型及得分

- Cgroup内存配额情况

性能调优进阶技术

大页内存配置实战

Oracle数据库HugePages计算:

#!/bin/bash

# 计算推荐的HugePages数量

PGTOTAL=$(grep MemTotal /proc/meminfo | awk '{print $2}')

PGHUGEPAGES=$((($PGTOTAL-1048576)/2048))

# 预留5%缓冲

PGHUGEPAGES=$(($PGHUGEPAGES*95/100))

echo "Recommended HugePages: $PGHUGEPAGES"

echo "vm.nr_hugepages=$PGHUGEPAGES" >> /etc/sysctl.conf

sysctl -p

透明大页(THP)调优指南:

# 查看当前THP状态

cat /sys/kernel/mm/transparent_hugepage/enabled

# 针对性优化方案

case $WORKLOAD_TYPE in

"OLTP")

echo "madvise" > /sys/kernel/mm/transparent_hugepage/enabled

;;

"OLAP")

echo "always" > /sys/kernel/mm/transparent_hugepage/enabled

;;

"In-Memory")

echo "never" > /sys/kernel/mm/transparent_hugepage/enabled

;;

esac

Cgroups v2内存限制

现代Linux系统推荐配置:

# 创建内存限制组 mkdir -p /sys/fs/cgroup/memory/limited_app # 设置内存限制(含Swap) echo "2G" > /sys/fs/cgroup/memory/limited_app/memory.max echo "1G" > /sys/fs/cgroup/memory/limited_app/memory.swap.max # 启用内存压力通知 echo "1000 5000" > /sys/fs/cgroup/memory/limited_app/memory.pressure # 添加进程 echo <pid> > /sys/fs/cgroup/memory/limited_app/cgroup.procs

高级控制参数:

memory.high:软限制,触发回收memory.low:保护性最低保障memory.zswap.max:限制Zswap使用量

最佳实践与架构建议

内存优化检查清单

-

基础配置:

- [ ] Swap分区大小为物理内存1-2倍

- [ ] 正确配置Swappiness值

- [ ] 启用内存压缩技术

-

监控体系:

- [ ] 部署实时内存监控

- [ ] 设置合理的告警阈值

- [ ] 定期分析内存趋势

-

应用优化:

- [ ] 关键进程OOM保护

- [ ] 合理设置应用内存限制

- [ ] 优化数据访问模式

云原生环境特别建议

-

容器内存管理:

# Kubernetes示例 resources: limits: memory: "4Gi" hugepages-2Mi: "1Gi" requests: memory: "3Gi" -

Sidecar代理优化:

- 为Istio等代理配置独立内存Cgroup

- 启用内存压缩

- 监控代理内存增长

-

Serverless环境:

- 预加载常用库减少冷启动

- 使用内存池技术

- 优化临时文件使用

通过本文介绍的系统化方法,结合现代Linux内核提供的内存管理特性,可以构建高效、稳定的内存管理体系,满足从传统物理服务器到云原生环境的各种需求,建议定期复查内存配置,保持与业务发展的同步优化。

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们。